- 产品简介

- 购买指南

- 快速入门

- 操作指南

- 开发指南

- 客户端访问

- 实践教程

- SQL 语法

- SuperSQL 语法

- SuperSQL 语法概览

- 统一语法

- 常用数据类型

- DDL 语法

- CREATE DATABASE

- SHOW DATABASES

- DESCRIBE DATABASE

- ALTER DATABASE

- DROP DATABASE

- CREATE TABLE

- REPLACE TABLE AS SELECT

- SHOW TABLES

- SHOW CREATE TABLE

- SHOW TBLPROPERTIES

- DESCRIBE TABLE

- SHOW COLUMNS IN TABLE

- ALTER TABLE

- ALTER TABLE ADD COLUMNS

- ALTER TABLE ADD COLUMN AFTER/FIRST

- ALTER TABLE DROP COLUMN

- ALTER TABLE ADD PARTATION

- SHOW PARTITIONS

- ALTER TABLE DROP PARTITION

- ALTER TABLE ADD PARTITION FIELD

- ALTER TABLE DROP PARTITION FIELD

- ALTER TABLE ... RENAME COLUMN

- ALTER TABLE SET TBLPROPERTIES

- ALTER TABLE SET LOCATION

- ALTER TABLE ... WRITE ORDERED BY

- ALTER TABLE ... WRITE DISTRIBUTED BY PARTITION

- ALTER TABLE ... SET IDENTIFIER FIELDS

- ALTER TABLE ... DROP IDENTIFIER FIELDS

- MSCK REPAIR TABLE

- ANALYZE TABLES

- DROP TABLE

- EXPLAIN

- CALL STATEMENT

- CREATE VIEW AS

- SHOW VIEWS

- DESCRIBE VIEW

- SHOW CREATE VIEW

- SHOW COLUMNS IN VIEW

- ALTER VIEW

- DROP VIEW

- CREATE FUNCTION

- SHOW FUNCTION

- DROP FUNCTION

- DML 语法

- DQL 语法

- Iceberg 表语法

- 物化视图语法

- SQL 隐式转换

- 函数

- 标准 Spark 语法概览

- 标准 Presto 语法概览

- 保留字

- SuperSQL 语法

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- Data Table APIs

- Task APIs

- CreateSparkSessionBatchSQL

- CancelSparkSessionBatchSQL

- CancelTask

- CreateResultDownload

- CreateSparkAppTask

- CreateTask

- CreateTasks

- DeleteSparkApp

- DescribeEngineUsageInfo

- DescribeResultDownload

- DescribeSparkAppTasks

- DescribeTaskResult

- DescribeTasks

- QueryTaskCostDetail

- CreateSparkApp

- DescribeSparkAppJob

- DescribeSparkSessionBatchSqlLog

- ModifySparkApp

- DescribeSparkAppJobs

- ModifySparkAppBatch

- DescribeTaskStatistics

- DescribeQuery

- DescribeJobs

- DescribeJob

- Metadata APIs

- Service Configuration APIs

- CreateCHDFSBindingProduct

- DeleteCHDFSBindingProduct

- DescribeOtherCHDFSBindingList

- CreateStoreLocation

- DescribeStoreLocation

- ModifyDataEngineDescription

- RollbackDataEngineImage

- SwitchDataEngine

- SwitchDataEngineImage

- UpgradeDataEngineImage

- DeleteThirdPartyAccessUser

- DescribeDataEngineImageVersions

- DescribeSubUserAccessPolicy

- DescribeThirdPartyAccessUser

- RegisterThirdPartyAccessUser

- RestartDataEngine

- UpdateUserDataEngineConfig

- UpdateDataEngineConfig

- Permission Management APIs

- AddUsersToWorkGroup

- AttachUserPolicy

- AttachWorkGroupPolicy

- BindWorkGroupsToUser

- CreateUser

- CreateWorkGroup

- DeleteUser

- DeleteUsersFromWorkGroup

- DeleteWorkGroup

- DescribeUserInfo

- DescribeUserRoles

- DescribeUserType

- DescribeUsers

- DescribeWorkGroupInfo

- DescribeWorkGroups

- DetachUserPolicy

- DetachWorkGroupPolicy

- ModifyUser

- ModifyUserType

- ModifyWorkGroup

- UnbindWorkGroupsFromUser

- UpdateRowFilter

- CheckGrantedPermission

- Database APIs

- Data Source Connection APIs

- Data Optimization APIs

- Data Engine APIs

- Data Types

- Error Codes

- 通用类参考

- DLC 政策

- 服务等级协议

- 联系我们

- 产品简介

- 购买指南

- 快速入门

- 操作指南

- 开发指南

- 客户端访问

- 实践教程

- SQL 语法

- SuperSQL 语法

- SuperSQL 语法概览

- 统一语法

- 常用数据类型

- DDL 语法

- CREATE DATABASE

- SHOW DATABASES

- DESCRIBE DATABASE

- ALTER DATABASE

- DROP DATABASE

- CREATE TABLE

- REPLACE TABLE AS SELECT

- SHOW TABLES

- SHOW CREATE TABLE

- SHOW TBLPROPERTIES

- DESCRIBE TABLE

- SHOW COLUMNS IN TABLE

- ALTER TABLE

- ALTER TABLE ADD COLUMNS

- ALTER TABLE ADD COLUMN AFTER/FIRST

- ALTER TABLE DROP COLUMN

- ALTER TABLE ADD PARTATION

- SHOW PARTITIONS

- ALTER TABLE DROP PARTITION

- ALTER TABLE ADD PARTITION FIELD

- ALTER TABLE DROP PARTITION FIELD

- ALTER TABLE ... RENAME COLUMN

- ALTER TABLE SET TBLPROPERTIES

- ALTER TABLE SET LOCATION

- ALTER TABLE ... WRITE ORDERED BY

- ALTER TABLE ... WRITE DISTRIBUTED BY PARTITION

- ALTER TABLE ... SET IDENTIFIER FIELDS

- ALTER TABLE ... DROP IDENTIFIER FIELDS

- MSCK REPAIR TABLE

- ANALYZE TABLES

- DROP TABLE

- EXPLAIN

- CALL STATEMENT

- CREATE VIEW AS

- SHOW VIEWS

- DESCRIBE VIEW

- SHOW CREATE VIEW

- SHOW COLUMNS IN VIEW

- ALTER VIEW

- DROP VIEW

- CREATE FUNCTION

- SHOW FUNCTION

- DROP FUNCTION

- DML 语法

- DQL 语法

- Iceberg 表语法

- 物化视图语法

- SQL 隐式转换

- 函数

- 标准 Spark 语法概览

- 标准 Presto 语法概览

- 保留字

- SuperSQL 语法

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- Data Table APIs

- Task APIs

- CreateSparkSessionBatchSQL

- CancelSparkSessionBatchSQL

- CancelTask

- CreateResultDownload

- CreateSparkAppTask

- CreateTask

- CreateTasks

- DeleteSparkApp

- DescribeEngineUsageInfo

- DescribeResultDownload

- DescribeSparkAppTasks

- DescribeTaskResult

- DescribeTasks

- QueryTaskCostDetail

- CreateSparkApp

- DescribeSparkAppJob

- DescribeSparkSessionBatchSqlLog

- ModifySparkApp

- DescribeSparkAppJobs

- ModifySparkAppBatch

- DescribeTaskStatistics

- DescribeQuery

- DescribeJobs

- DescribeJob

- Metadata APIs

- Service Configuration APIs

- CreateCHDFSBindingProduct

- DeleteCHDFSBindingProduct

- DescribeOtherCHDFSBindingList

- CreateStoreLocation

- DescribeStoreLocation

- ModifyDataEngineDescription

- RollbackDataEngineImage

- SwitchDataEngine

- SwitchDataEngineImage

- UpgradeDataEngineImage

- DeleteThirdPartyAccessUser

- DescribeDataEngineImageVersions

- DescribeSubUserAccessPolicy

- DescribeThirdPartyAccessUser

- RegisterThirdPartyAccessUser

- RestartDataEngine

- UpdateUserDataEngineConfig

- UpdateDataEngineConfig

- Permission Management APIs

- AddUsersToWorkGroup

- AttachUserPolicy

- AttachWorkGroupPolicy

- BindWorkGroupsToUser

- CreateUser

- CreateWorkGroup

- DeleteUser

- DeleteUsersFromWorkGroup

- DeleteWorkGroup

- DescribeUserInfo

- DescribeUserRoles

- DescribeUserType

- DescribeUsers

- DescribeWorkGroupInfo

- DescribeWorkGroups

- DetachUserPolicy

- DetachWorkGroupPolicy

- ModifyUser

- ModifyUserType

- ModifyWorkGroup

- UnbindWorkGroupsFromUser

- UpdateRowFilter

- CheckGrantedPermission

- Database APIs

- Data Source Connection APIs

- Data Optimization APIs

- Data Engine APIs

- Data Types

- Error Codes

- 通用类参考

- DLC 政策

- 服务等级协议

- 联系我们

数据湖计算 DLC 为您提供两类引擎:标准引擎和 SuperSQL 引擎,具体区别可参考以下表格或详见 标准引擎介绍。您可以根据实际业务诉求,选择合适的引擎进行使用。如选择标准引擎,您可根据本文档进行配置及使用。

引擎类型 | 可选类型 | 主要特点 | 使用约束 | 选购建议 |

标准引擎 | spark

presto | 一体化 Spark:标准 Spark 引擎可执原生语法:Spark/Presto 社区原生语法,学习、迁移成本低 使用灵活:支持 Hive JDBC 及 Presto JDBC 一体化 Spark:标准 Spark 引擎可执行 SQL及 Spark 批任务 | 1. 需使用 Spark/Presto 原生语法。 2. 希望购买一个 Spark 引擎完成批作业及离线 SQL 任务。 3. 希望使用 Hive JDBC 及 Presto JDBC。 | |

SuperSQL 引擎 | sparkSQL

spark 作业

presto | 统一语法:同一套语法适用于Spark 及 Presto 引擎 支持联邦查询 | 需学习 SuperSQL 统一语法

SQL/批任务场景建议购买对应类型引擎 | 1.希望使用 Spark + Presto 统一语法。 2.需要使用联邦查询。 |

注意:

1. 购买前,请确认您的账号是否已在 CAM 中开通财务权限。

2. 资源无法跨地域使用,购买前请确认当前地域是否正确。

标准引擎配置指引

在完成标准引擎的购买与配置后,您即可在 DLC 数据探索中使用标准引擎,此外针对 Spark 标准引擎,如果有多租户或任务隔离需求,您另可在配置用于资源分配与隔离的标准引擎资源组,具体指引如下:

第一步:购买引擎

说明:

1. 引擎不支持跨地域使用

2. 引擎规格建议:由于16CUs的集群规模较小,建议仅用于测试场景,真实生产场景建议选择购买64CUs以上规格的集群。

3. 引擎网络配置:首次开通购买时,允许配置自定义网络配置,后续如需更改,请提交工单申请

第二步:使用数据探索

选择标准引擎进行查询

说明:

根据标准引擎的类型不同,您需要切换对应的语法进行查询。

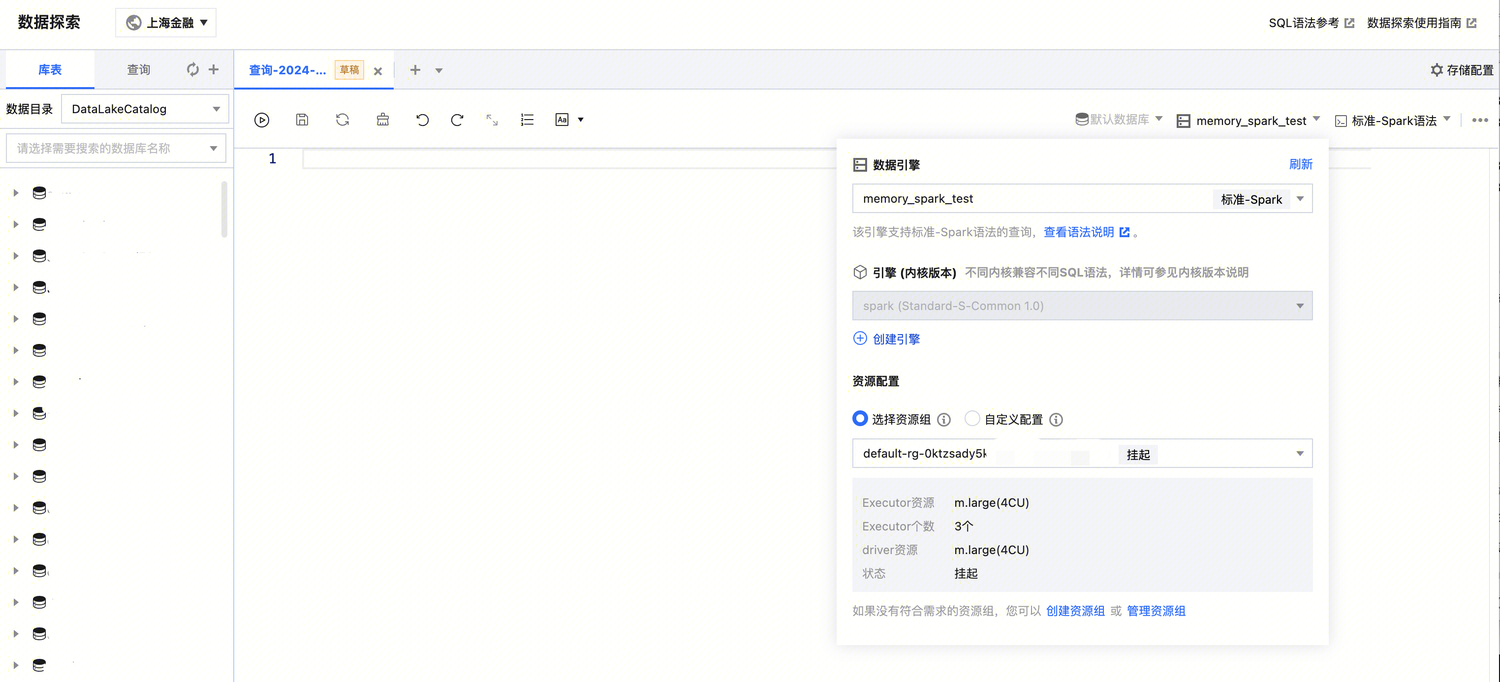

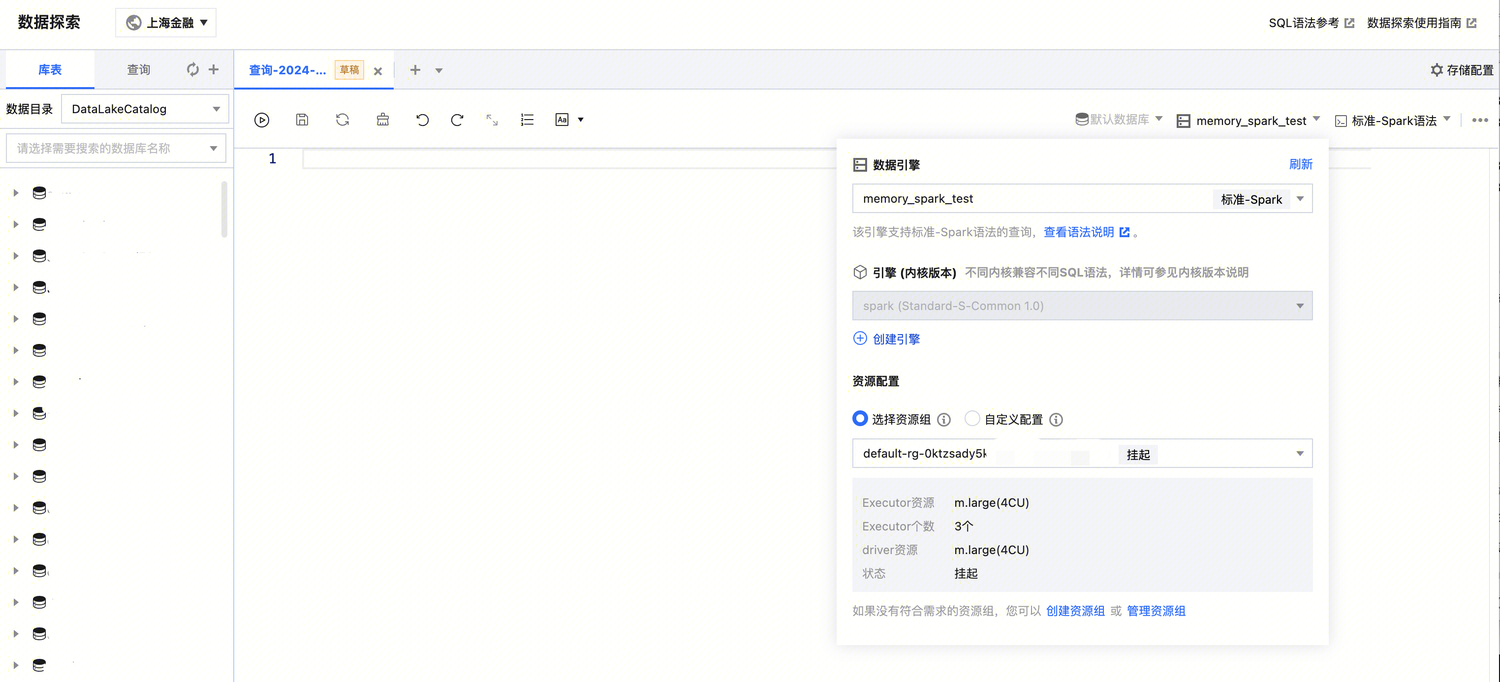

如您在数据探索选择的引擎类型为标准 Spark 引擎时,您可以通过使用 DLC 默认资源组、已创建的资源组或使用一次性资源组(自定义配置)进行任务资源分配。

获取全量结果

标准引擎目前仅支持工作台返回1000条查询结果,全量结果获取可参考以下方式:

使用引擎 | 获取方式 |

标准 Spark 引擎 | 1. 支持用户通过配置将查询结果自动保存至 COS 路径下或 DLC 的托管存储查看 2. 下载至本地查看 |

标准 Presto 引擎 | 通过 JDBC 获取全量结果获取。 |

第三步:配置资源组(非必选)

资源组是对 Spark 标准引擎计算资源的二级队列划分,具体介绍可参考 资源组介绍。DLC Spark 标准引擎的计算单元(CU)可按需被划分到多个资源组中,并设置每个资源组可使用CU数量的最小值和上限、启停策略、并发数和动静态参数等,从而满足多租户、多任务等复杂场景下的计算资源隔离与工作负载的高效管理。

当您购买的引擎为标准 Spark 引擎时,数据湖计算 DLC 会为您提供默认资源组及支持您可以根据实际业务诉求,生成多个自定义资源资源组灵活使用。

说明:

引擎与资源组为一对多关系,例如,引擎 A 下,可以有若干个资源组。

管理与配置资源组

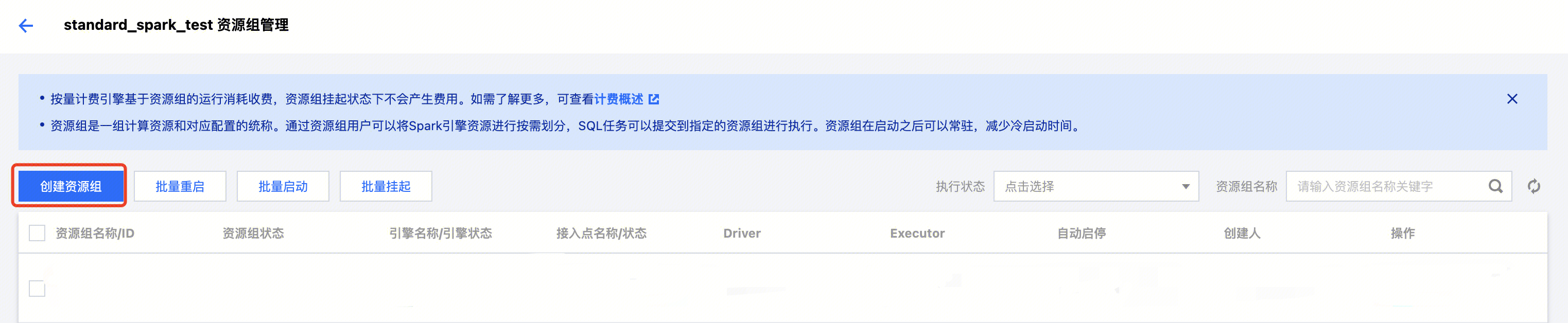

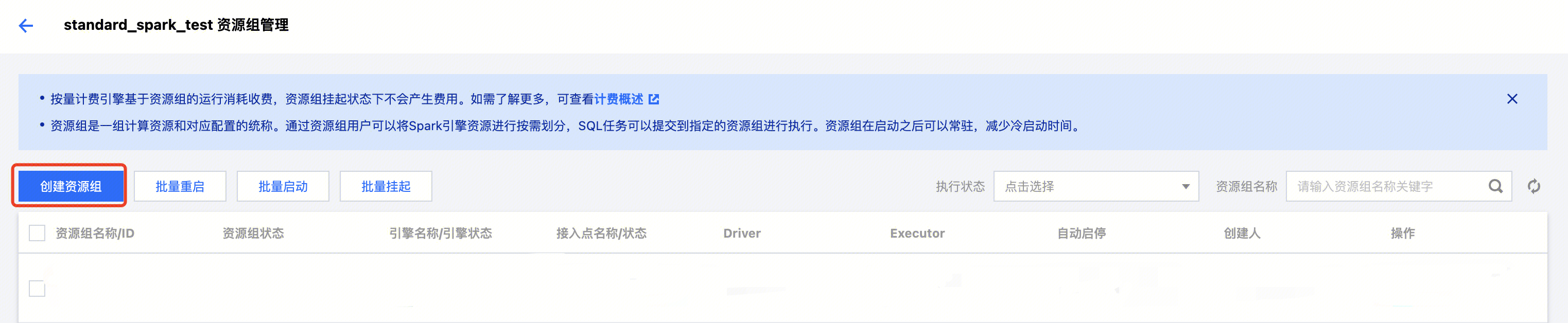

1. 单击进入对应引擎的资源组管理。

2. 进入资源管理组界面,单击创建资源组,进行自定义资源组配置。或查看使用 DLC 默认配置资源组(无需配置)。

附录

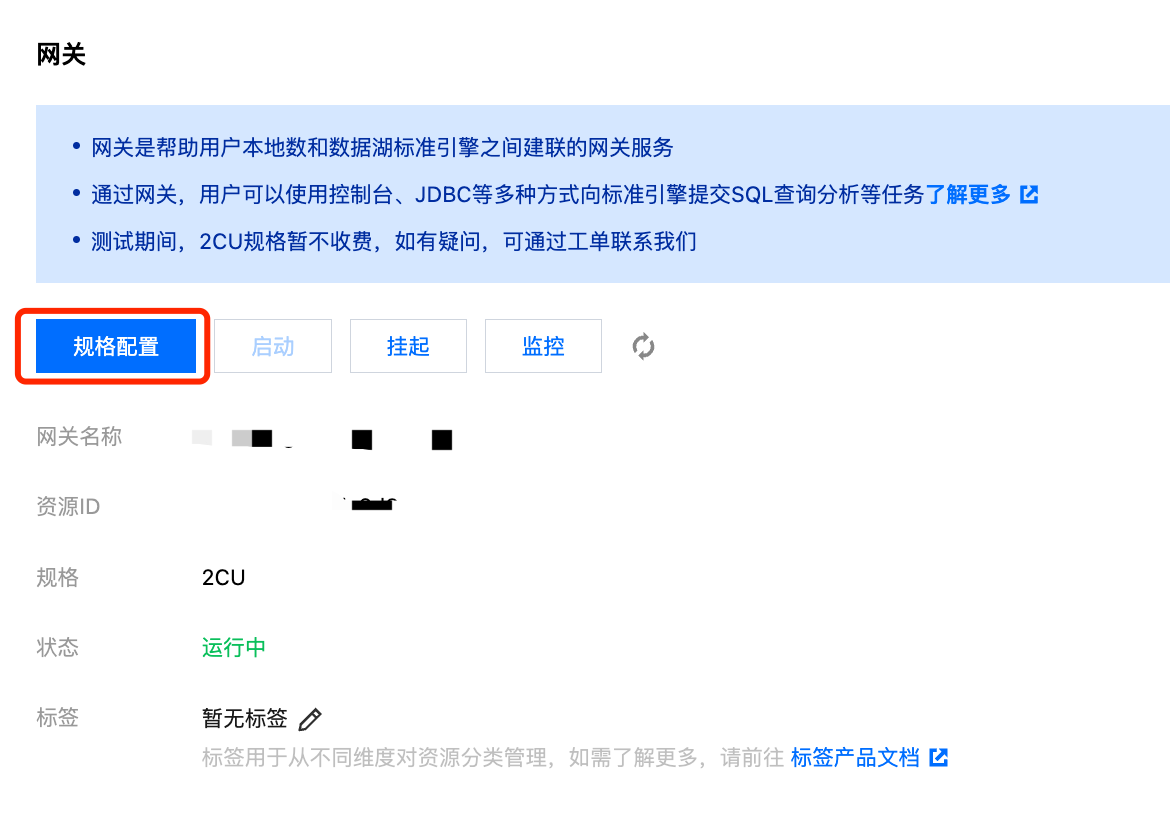

关于网关规格选择建议

网关规格 | Spark Batch 瞬时并发提交任务数/并行运行任务数 | Spark SQL /Presto SQL 并发查询 | Presto 引擎管理数量 | Spark 资源组管理数量 | 网关是否 HA |

2CU | 30/50 | 100 | 4 | 50 | 否 |

16CU | 80/150 | 250 | 12 | 150 | 是 |

32CU | 220/400 | 600 | 35 | 400 | 是 |

64CU | 400/600 | 1000 | 70 | 700 | 是 |

注意:

网关默认提供规格为2CU(不收费),如有升配需求。可通过点击网关详情→选择规格配置进行调整购买

是

是

否

否

本页内容是否解决了您的问题?