- 产品简介

- 购买指南

- 准备工作

- 操作指南

- 管理控制台

- 项目管理

- 数据集成

- 数据集成概述

- 支持的数据源与读写能力

- 集成资源配置与管理

- 实时同步任务配置与运维

- 离线同步任务配置与运维

- 离线同步支持的数据源

- 数据源一览

- 数据源列表

- MySQL 数据源

- TDSQL-C MySQL 数据源

- Oracle 数据源

- SQL Server 数据源

- PostgreSQL 数据源

- TDSQL-PostgreSQL 数据源

- TDSQL MySQL 数据源

- DB2 数据源

- 达梦 DM 数据源

- OceanBase 数据源

- SAP HANA 数据源

- SAP IQ(Sybase) 数据源

- Doris/TCHouse-D 数据源

- StarRocks 数据源

- DLC 数据源

- Iceberg 数据源

- TCHouse-P 数据源

- ClickHouse 数据源

- Greenplum 数据源

- Hive 数据源

- HDFS 数据源

- HBase 数据源

- TBase 数据源

- GBase 数据源

- GaussDB 数据源

- Impala 数据源

- Kudu 数据源

- FTP 数据源

- COS 数据源

- SFTP 数据源

- Rest API 数据源

- Elasticsearch/腾讯云 Elasticsearch 数据源

- Mongo/腾讯云 Mongo 数据源

- Redis 数据源

- Kafka/CKafka 数据源

- CTSDB influxDB 数据源

- TDMQ Pulsar 数据源

- 数据集成离线同步配置与运维

- 数据开发离线同步配置与运维

- 转换节点配置

- 时间参数说明

- 离线节点高级参数

- 离线同步支持的数据源

- 同步任务自动建表能力

- 常见问题

- 数据开发

- 数据资产

- 数据质量

- 数据安全

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- Smart Ops Related Interfaces

- Data Development APIs

- DeleteProjectParamDs

- CreateWorkflowDs

- CreateTaskVersionDs

- RemoveWorkflowDs

- TriggerDsEvent

- DeleteTaskDs

- DescribeBatchOperateTask

- DeleteFilePath

- GetFileInfo

- FindAllFolder

- CreateTaskFolder

- MoveTasksToFolder

- DescribeDsFolderTree

- DeleteFile

- UploadContent

- SubmitSqlTask

- SubmitTaskTestRun

- DeleteResource

- DescribeResourceManagePathTrees

- CreateCustomFunction

- DeleteCustomFunction

- DescribeFunctionKinds

- DescribeFunctionTypes

- DescribeOrganizationalFunctions

- SaveCustomFunction

- SubmitCustomFunction

- CreateDsFolder

- DeleteDsFolder

- DescribeDsParentFolderTree

- ModifyDsFolder

- DeleteResourceFile

- DeleteResourceFiles

- Data Operations Related Interfaces

- Metadata Related Interfaces

- Task Operation and Maintenance APIs

- FreezeTasksByWorkflowIds

- DeleteWorkflowById

- DescribeDependTaskLists

- DescribeWorkflowExecuteById

- DescribeWorkflowTaskCount

- DescribeWorkflowListByProjectId

- DescribeWorkflowInfoById

- UpdateWorkflowOwner

- RunRerunScheduleInstances

- DescribeWorkflowCanvasInfo

- DescribeAllByFolderNew

- DescribeTaskRunHistory

- RunForceSucScheduleInstances

- KillScheduleInstances

- RunTasksByMultiWorkflow

- DescribeTaskByStatusReport

- DescribeStatisticInstanceStatusTrendOps

- DescribeOpsWorkflows

- DescribeSchedulerTaskTypeCnt

- BatchStopWorkflowsByIds

- DescribeInstanceByCycle

- DescribeTaskByCycleReport

- DescribeSchedulerInstanceStatus

- DescribeScheduleInstances

- CreateOpsMakePlan

- DescribeSchedulerTaskCntByStatus

- DescribeSchedulerRunTimeInstanceCntByStatus

- DescribeOpsMakePlanInstances

- DescribeOpsMakePlanTasks

- DescribeOpsMakePlans

- KillOpsMakePlanInstances

- BatchDeleteOpsTasks

- DescribeFolderWorkflowList

- DescribeTaskScript

- ModifyTaskInfo

- ModifyTaskLinks

- ModifyTaskScript

- ModifyWorkflowSchedule

- RegisterEvent

- RegisterEventListener

- SetTaskAlarmNew

- SubmitTask

- SubmitWorkflow

- TriggerEvent

- BatchModifyOpsOwners

- BatchStopOpsTasks

- CountOpsInstanceState

- DescribeDependOpsTasks

- DescribeOperateOpsTasks

- DescribeSuccessorOpsTaskInfos

- FreezeOpsTasks

- CreateTask

- ModifyWorkflowInfo

- Instance Operation and Maintenance Related Interfaces

- Data Map and Data Dictionary APIs

- Data Quality Related Interfaces

- CommitRuleGroupTask

- CreateRule

- CreateRuleTemplate

- DeleteRule

- DeleteRuleTemplate

- DescribeDataCheckStat

- DescribeDimensionScore

- DescribeExecStrategy

- DescribeQualityScore

- DescribeQualityScoreTrend

- DescribeRule

- DescribeRuleDimStat

- DescribeRuleExecDetail

- DescribeRuleExecLog

- DescribeRuleExecResults

- DescribeRuleExecStat

- DescribeRuleGroup

- DescribeRuleGroupExecResultsByPage

- DescribeRuleGroupSubscription

- DescribeRuleGroupTable

- DescribeRuleGroupsByPage

- DescribeRuleTemplate

- DescribeRuleTemplates

- DescribeRules

- DescribeRulesByPage

- DescribeTableQualityDetails

- DescribeTableScoreTrend

- DescribeTemplateDimCount

- DescribeTopTableStat

- DescribeTrendStat

- ModifyDimensionWeight

- ModifyExecStrategy

- ModifyMonitorStatus

- ModifyRule

- ModifyRuleGroupSubscription

- ModifyRuleTemplate

- DataInLong APIs

- BatchCreateIntegrationTaskAlarms

- BatchDeleteIntegrationTasks

- BatchForceSuccessIntegrationTaskInstances

- BatchKillIntegrationTaskInstances

- BatchMakeUpIntegrationTasks

- BatchRerunIntegrationTaskInstances

- BatchResumeIntegrationTasks

- BatchStartIntegrationTasks

- BatchStopIntegrationTasks

- BatchSuspendIntegrationTasks

- BatchUpdateIntegrationTasks

- CheckAlarmRegularNameExist

- CheckIntegrationNodeNameExists

- CheckIntegrationTaskNameExists

- CheckTaskNameExist

- CommitIntegrationTask

- CreateHiveTable

- CreateHiveTableByDDL

- CreateIntegrationNode

- CreateIntegrationTask

- CreateTaskAlarmRegular

- DeleteIntegrationNode

- DeleteIntegrationTask

- DeleteOfflineTask

- DeleteTaskAlarmRegular

- DescribeAlarmEvents

- DescribeAlarmReceiver

- DescribeInstanceLastLog

- DescribeInstanceList

- DescribeInstanceLog

- DescribeInstanceLogList

- DescribeIntegrationNode

- DescribeIntegrationStatistics

- DescribeIntegrationStatisticsInstanceTrend

- DescribeIntegrationStatisticsRecordsTrend

- DescribeIntegrationStatisticsTaskStatus

- DescribeIntegrationStatisticsTaskStatusTrend

- DescribeIntegrationTask

- DescribeIntegrationTasks

- DescribeIntegrationVersionNodesInfo

- DescribeOfflineTaskToken

- DescribeRealTimeTaskInstanceNodeInfo

- DescribeRealTimeTaskSpeed

- DescribeRuleTemplatesByPage

- DescribeStreamTaskLogList

- DescribeTaskAlarmRegulations

- DescribeTaskLockStatus

- DryRunDIOfflineTask

- GenHiveTableDDLSql

- GetIntegrationNodeColumnSchema

- GetOfflineDIInstanceList

- GetOfflineInstanceList

- LockIntegrationTask

- ModifyIntegrationNode

- ModifyIntegrationTask

- ModifyTaskAlarmRegular

- ModifyTaskName

- ResumeIntegrationTask

- RobAndLockIntegrationTask

- StartIntegrationTask

- StopIntegrationTask

- SuspendIntegrationTask

- TaskLog

- UnlockIntegrationTask

- CreateOfflineTask

- DescribeRealTimeTaskMetricOverview

- Platform management related APIs

- Data Source Management APIs

- Data Types

- Error Codes

- 服务等级协议

- 相关协议

- 联系我们

- 词汇表

- 产品简介

- 购买指南

- 准备工作

- 操作指南

- 管理控制台

- 项目管理

- 数据集成

- 数据集成概述

- 支持的数据源与读写能力

- 集成资源配置与管理

- 实时同步任务配置与运维

- 离线同步任务配置与运维

- 离线同步支持的数据源

- 数据源一览

- 数据源列表

- MySQL 数据源

- TDSQL-C MySQL 数据源

- Oracle 数据源

- SQL Server 数据源

- PostgreSQL 数据源

- TDSQL-PostgreSQL 数据源

- TDSQL MySQL 数据源

- DB2 数据源

- 达梦 DM 数据源

- OceanBase 数据源

- SAP HANA 数据源

- SAP IQ(Sybase) 数据源

- Doris/TCHouse-D 数据源

- StarRocks 数据源

- DLC 数据源

- Iceberg 数据源

- TCHouse-P 数据源

- ClickHouse 数据源

- Greenplum 数据源

- Hive 数据源

- HDFS 数据源

- HBase 数据源

- TBase 数据源

- GBase 数据源

- GaussDB 数据源

- Impala 数据源

- Kudu 数据源

- FTP 数据源

- COS 数据源

- SFTP 数据源

- Rest API 数据源

- Elasticsearch/腾讯云 Elasticsearch 数据源

- Mongo/腾讯云 Mongo 数据源

- Redis 数据源

- Kafka/CKafka 数据源

- CTSDB influxDB 数据源

- TDMQ Pulsar 数据源

- 数据集成离线同步配置与运维

- 数据开发离线同步配置与运维

- 转换节点配置

- 时间参数说明

- 离线节点高级参数

- 离线同步支持的数据源

- 同步任务自动建表能力

- 常见问题

- 数据开发

- 数据资产

- 数据质量

- 数据安全

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- Smart Ops Related Interfaces

- Data Development APIs

- DeleteProjectParamDs

- CreateWorkflowDs

- CreateTaskVersionDs

- RemoveWorkflowDs

- TriggerDsEvent

- DeleteTaskDs

- DescribeBatchOperateTask

- DeleteFilePath

- GetFileInfo

- FindAllFolder

- CreateTaskFolder

- MoveTasksToFolder

- DescribeDsFolderTree

- DeleteFile

- UploadContent

- SubmitSqlTask

- SubmitTaskTestRun

- DeleteResource

- DescribeResourceManagePathTrees

- CreateCustomFunction

- DeleteCustomFunction

- DescribeFunctionKinds

- DescribeFunctionTypes

- DescribeOrganizationalFunctions

- SaveCustomFunction

- SubmitCustomFunction

- CreateDsFolder

- DeleteDsFolder

- DescribeDsParentFolderTree

- ModifyDsFolder

- DeleteResourceFile

- DeleteResourceFiles

- Data Operations Related Interfaces

- Metadata Related Interfaces

- Task Operation and Maintenance APIs

- FreezeTasksByWorkflowIds

- DeleteWorkflowById

- DescribeDependTaskLists

- DescribeWorkflowExecuteById

- DescribeWorkflowTaskCount

- DescribeWorkflowListByProjectId

- DescribeWorkflowInfoById

- UpdateWorkflowOwner

- RunRerunScheduleInstances

- DescribeWorkflowCanvasInfo

- DescribeAllByFolderNew

- DescribeTaskRunHistory

- RunForceSucScheduleInstances

- KillScheduleInstances

- RunTasksByMultiWorkflow

- DescribeTaskByStatusReport

- DescribeStatisticInstanceStatusTrendOps

- DescribeOpsWorkflows

- DescribeSchedulerTaskTypeCnt

- BatchStopWorkflowsByIds

- DescribeInstanceByCycle

- DescribeTaskByCycleReport

- DescribeSchedulerInstanceStatus

- DescribeScheduleInstances

- CreateOpsMakePlan

- DescribeSchedulerTaskCntByStatus

- DescribeSchedulerRunTimeInstanceCntByStatus

- DescribeOpsMakePlanInstances

- DescribeOpsMakePlanTasks

- DescribeOpsMakePlans

- KillOpsMakePlanInstances

- BatchDeleteOpsTasks

- DescribeFolderWorkflowList

- DescribeTaskScript

- ModifyTaskInfo

- ModifyTaskLinks

- ModifyTaskScript

- ModifyWorkflowSchedule

- RegisterEvent

- RegisterEventListener

- SetTaskAlarmNew

- SubmitTask

- SubmitWorkflow

- TriggerEvent

- BatchModifyOpsOwners

- BatchStopOpsTasks

- CountOpsInstanceState

- DescribeDependOpsTasks

- DescribeOperateOpsTasks

- DescribeSuccessorOpsTaskInfos

- FreezeOpsTasks

- CreateTask

- ModifyWorkflowInfo

- Instance Operation and Maintenance Related Interfaces

- Data Map and Data Dictionary APIs

- Data Quality Related Interfaces

- CommitRuleGroupTask

- CreateRule

- CreateRuleTemplate

- DeleteRule

- DeleteRuleTemplate

- DescribeDataCheckStat

- DescribeDimensionScore

- DescribeExecStrategy

- DescribeQualityScore

- DescribeQualityScoreTrend

- DescribeRule

- DescribeRuleDimStat

- DescribeRuleExecDetail

- DescribeRuleExecLog

- DescribeRuleExecResults

- DescribeRuleExecStat

- DescribeRuleGroup

- DescribeRuleGroupExecResultsByPage

- DescribeRuleGroupSubscription

- DescribeRuleGroupTable

- DescribeRuleGroupsByPage

- DescribeRuleTemplate

- DescribeRuleTemplates

- DescribeRules

- DescribeRulesByPage

- DescribeTableQualityDetails

- DescribeTableScoreTrend

- DescribeTemplateDimCount

- DescribeTopTableStat

- DescribeTrendStat

- ModifyDimensionWeight

- ModifyExecStrategy

- ModifyMonitorStatus

- ModifyRule

- ModifyRuleGroupSubscription

- ModifyRuleTemplate

- DataInLong APIs

- BatchCreateIntegrationTaskAlarms

- BatchDeleteIntegrationTasks

- BatchForceSuccessIntegrationTaskInstances

- BatchKillIntegrationTaskInstances

- BatchMakeUpIntegrationTasks

- BatchRerunIntegrationTaskInstances

- BatchResumeIntegrationTasks

- BatchStartIntegrationTasks

- BatchStopIntegrationTasks

- BatchSuspendIntegrationTasks

- BatchUpdateIntegrationTasks

- CheckAlarmRegularNameExist

- CheckIntegrationNodeNameExists

- CheckIntegrationTaskNameExists

- CheckTaskNameExist

- CommitIntegrationTask

- CreateHiveTable

- CreateHiveTableByDDL

- CreateIntegrationNode

- CreateIntegrationTask

- CreateTaskAlarmRegular

- DeleteIntegrationNode

- DeleteIntegrationTask

- DeleteOfflineTask

- DeleteTaskAlarmRegular

- DescribeAlarmEvents

- DescribeAlarmReceiver

- DescribeInstanceLastLog

- DescribeInstanceList

- DescribeInstanceLog

- DescribeInstanceLogList

- DescribeIntegrationNode

- DescribeIntegrationStatistics

- DescribeIntegrationStatisticsInstanceTrend

- DescribeIntegrationStatisticsRecordsTrend

- DescribeIntegrationStatisticsTaskStatus

- DescribeIntegrationStatisticsTaskStatusTrend

- DescribeIntegrationTask

- DescribeIntegrationTasks

- DescribeIntegrationVersionNodesInfo

- DescribeOfflineTaskToken

- DescribeRealTimeTaskInstanceNodeInfo

- DescribeRealTimeTaskSpeed

- DescribeRuleTemplatesByPage

- DescribeStreamTaskLogList

- DescribeTaskAlarmRegulations

- DescribeTaskLockStatus

- DryRunDIOfflineTask

- GenHiveTableDDLSql

- GetIntegrationNodeColumnSchema

- GetOfflineDIInstanceList

- GetOfflineInstanceList

- LockIntegrationTask

- ModifyIntegrationNode

- ModifyIntegrationTask

- ModifyTaskAlarmRegular

- ModifyTaskName

- ResumeIntegrationTask

- RobAndLockIntegrationTask

- StartIntegrationTask

- StopIntegrationTask

- SuspendIntegrationTask

- TaskLog

- UnlockIntegrationTask

- CreateOfflineTask

- DescribeRealTimeTaskMetricOverview

- Platform management related APIs

- Data Source Management APIs

- Data Types

- Error Codes

- 服务等级协议

- 相关协议

- 联系我们

- 词汇表

注意:

1. 当前用户在 EMR 集群有权限。

2. 已在 Hive 中创建对应的数据库和表,如示例中的:wedata_demo_db。

3. PySpark 系统自动使用 cluster 模式提交任务。

代码示例

from pyspark.sql import SparkSessionfrom pyspark.sql.types import StructType, StructField, IntegerType, StringTypespark = SparkSession.builder.appName("WeDataApp").getOrCreate()schema = StructType([StructField("user_id", IntegerType(), True),StructField("user_name", StringType(), True),StructField("age", IntegerType(), True)])data = [(1, "Alice", 25), (2, "Bob", 30)]df = spark.createDataFrame(data, schema=schema)df.show()

from pyspark.sql import SparkSession#spark = SparkSession.builder.appName("WeDataApp").enableHiveSupport().getOrCreate()#df = spark.sql("SELECT * FROM WeData_demo_db.user_demo")#count = df.count()#print("The number of rows in the dataframe is:", count)

参数说明

参数 | 说明 |

Python 版本 | 支持 Python2、Python3。 |

在 PySpark 任务中使用调度资源组的 Python 环境

在调度资源组中安装 Python 库

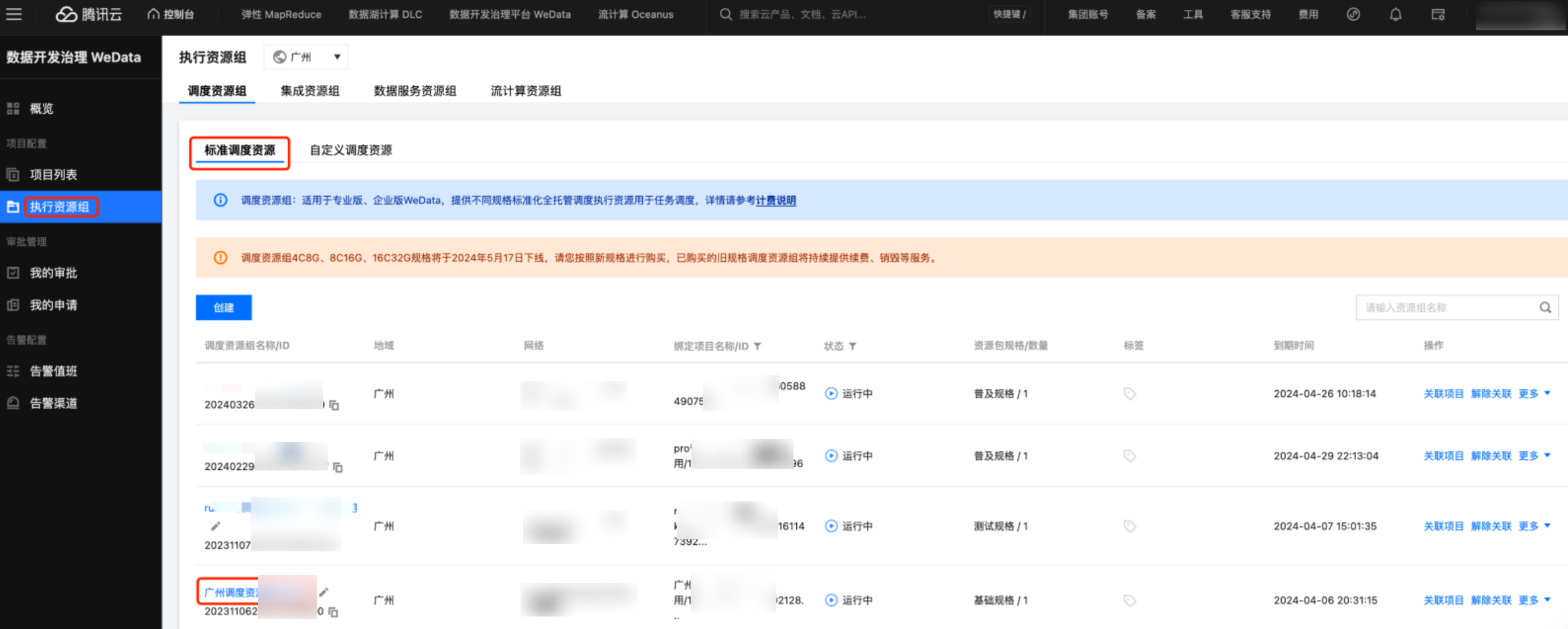

1. 进入项目管理 > 执行资源组 > 标准调度资源组界面,单击资源详情,进入资源运维界面。

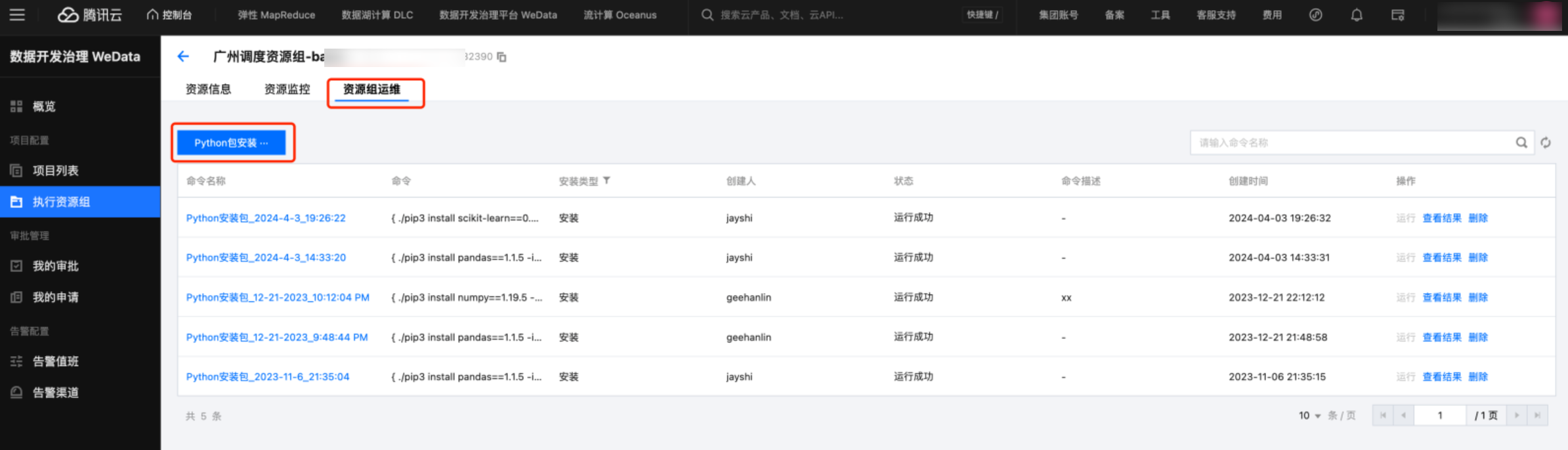

2. 在资源运维界面,单击 Python 包安装,可以安装内置的 Python 库,推荐安装 Python3 的版本。

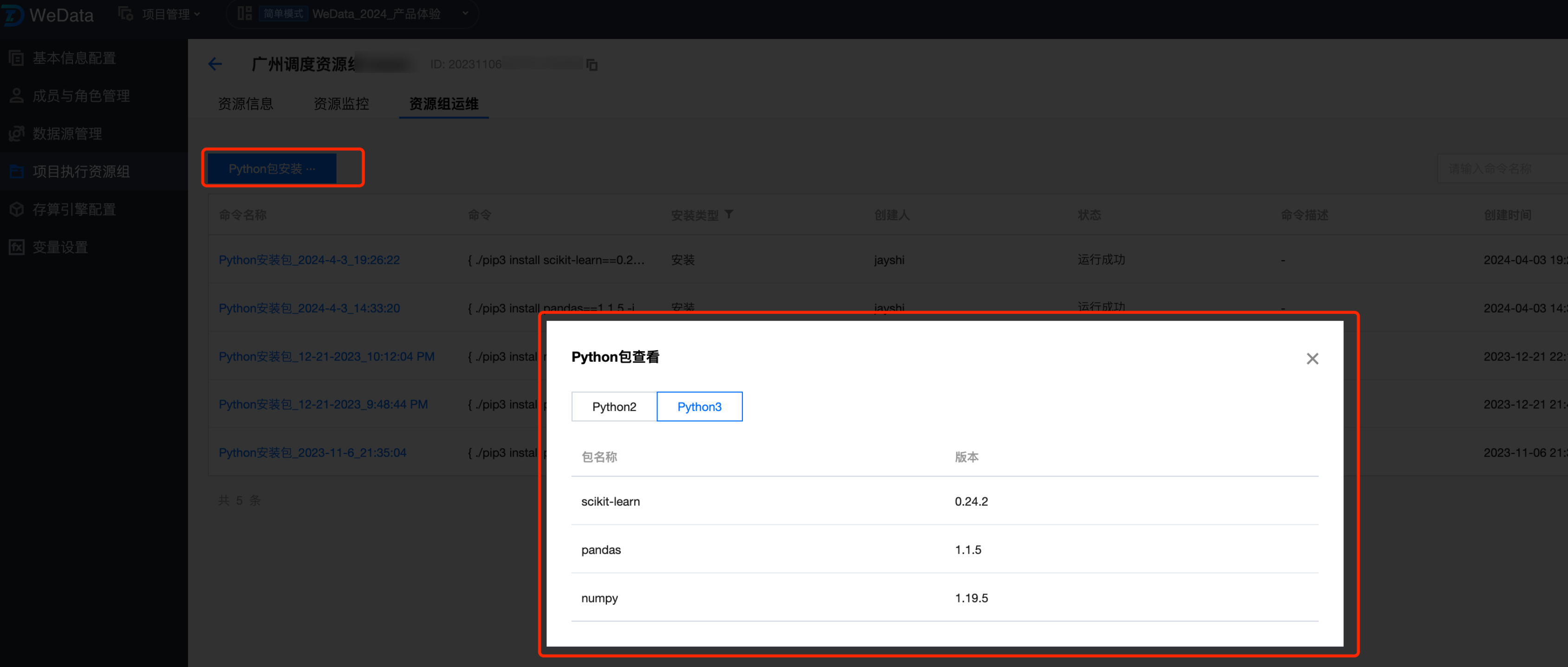

3. 目前平台只支持内置库的安装,这里安装 sklearn 和 pandas 库,安装完成后,可以通过 Python 包查看功能,查看已安装的 Python 库。

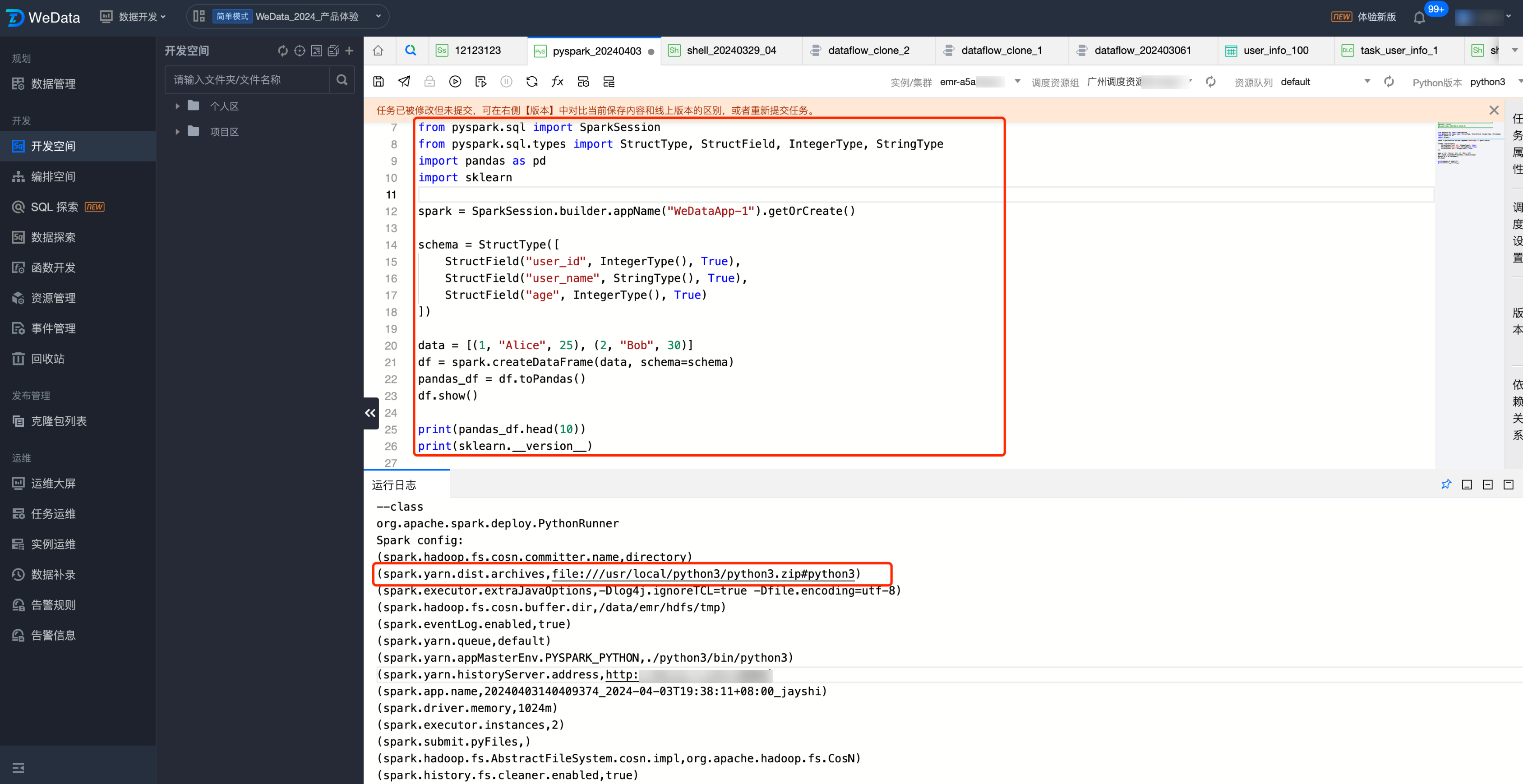

编辑 PySpark 任务

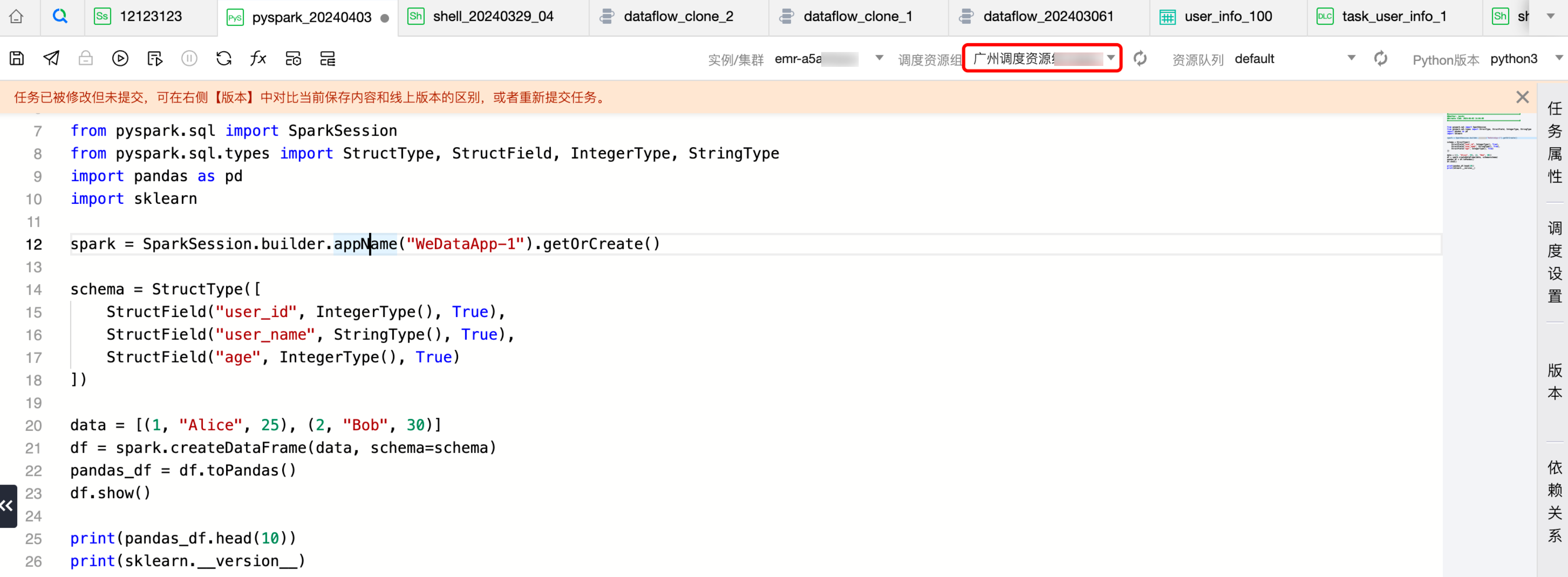

1. 创建任务,调度资源组选中安装了 Python 包的调度资源组。

2. 编写 PySpark 代码使用 Python 库,这里使用了 pandas 和 sklearn。

from pyspark.sql import SparkSession from pyspark.sql.types import StructType, StructField, IntegerType, StringType import pandas as pd import sklearn spark = SparkSession.builder.appName("WeDataApp-1").getOrCreate() schema = StructType([ StructField("user_id", IntegerType(), True), StructField("user_name", StringType(), True), StructField("age", IntegerType(), True) ]) data = [(1, "Alice", 25), (2, "Bob", 30)] df = spark.createDataFrame(data, schema=schema) pandas_df = df.toPandas() df.show() print(pandas_df.head(10)) print(sklearn.__version__)

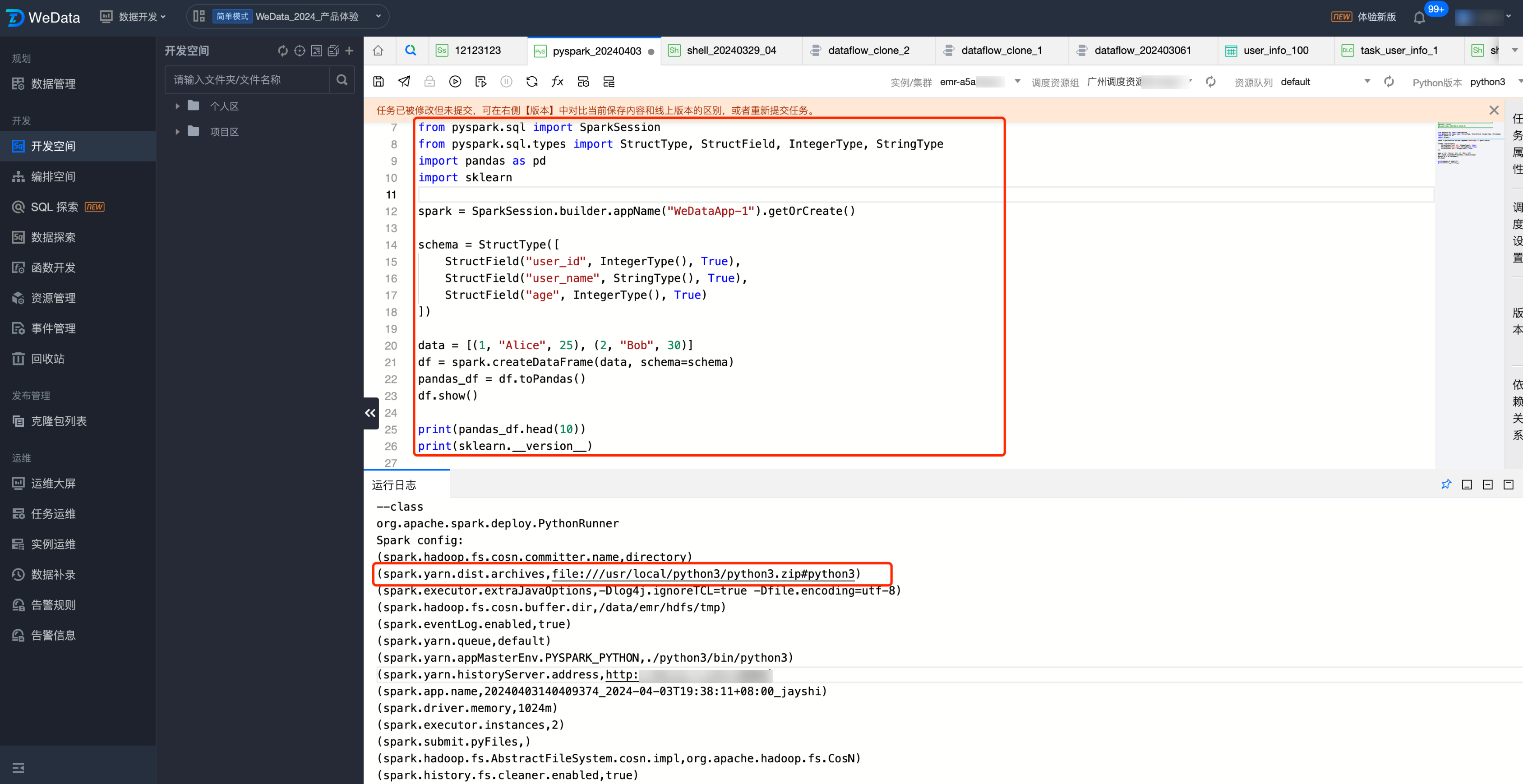

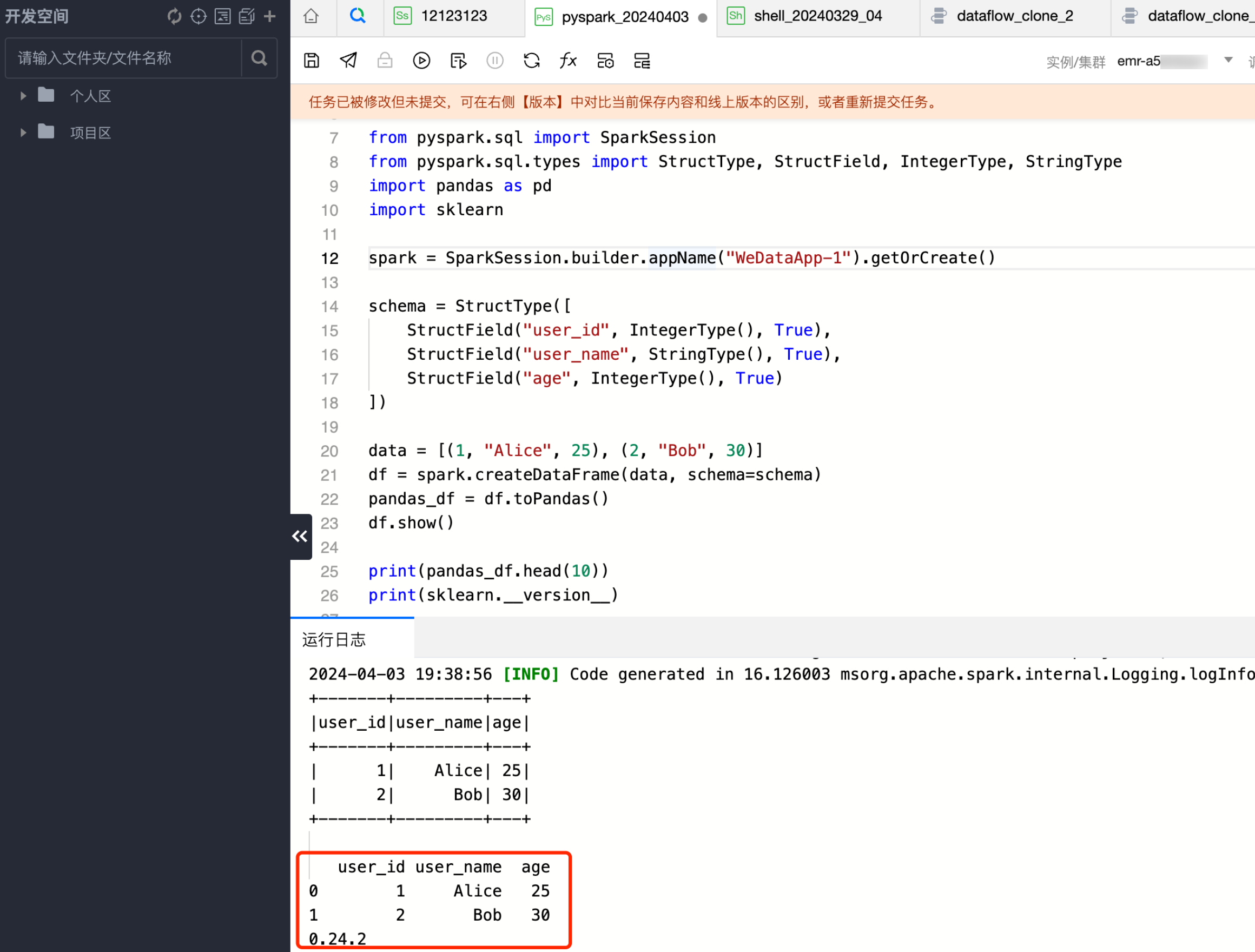

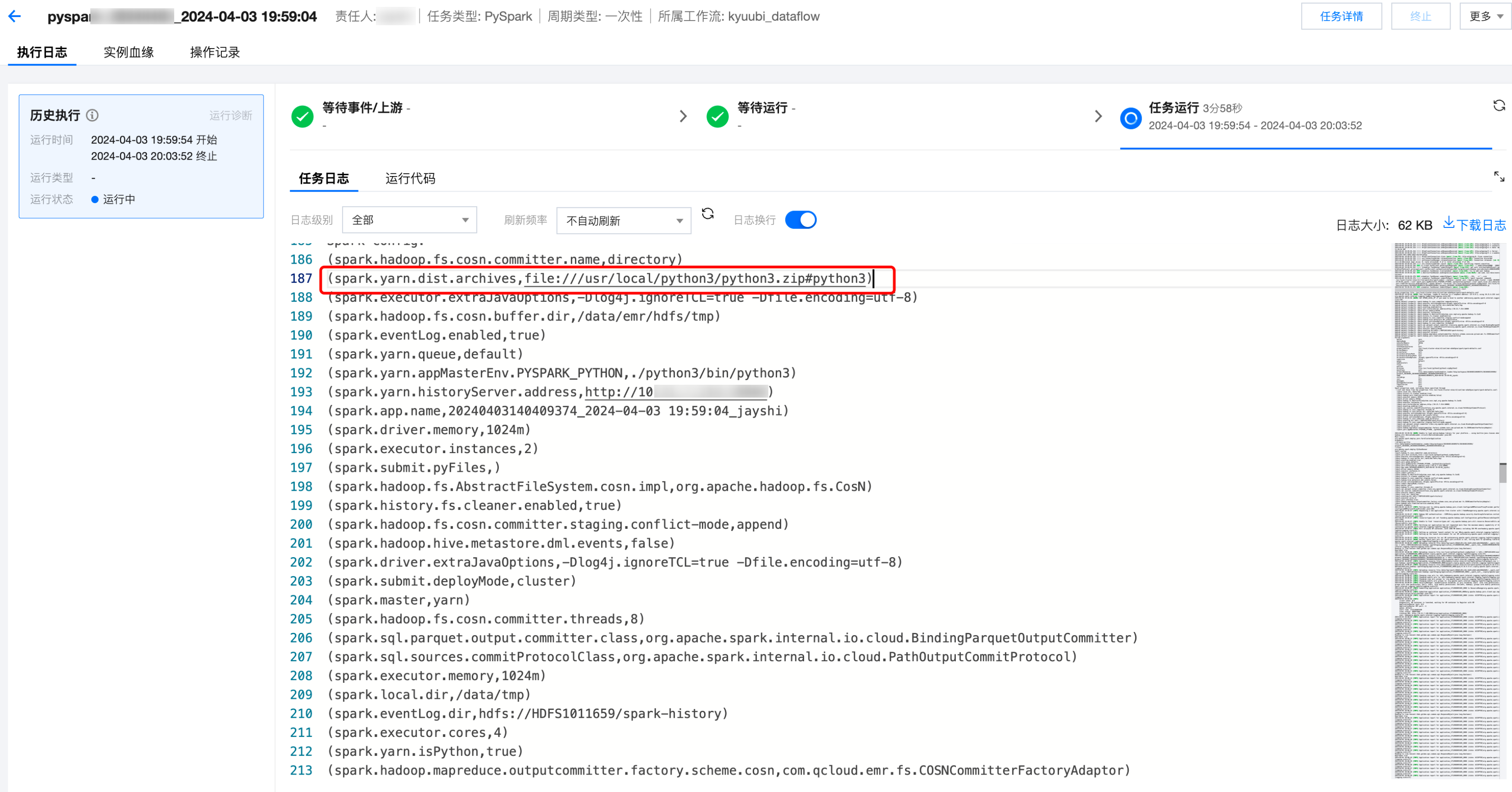

调试 PySpark 任务

1. 单击调试运行,查看调试运行的日志和结果。

示例:日志中可以查看使用调度资源组的 Python 环境作为任务运行的环境。

spark.yarn.dist.archives,file:///usr/local/python3/python3.zip#python3

2. 查看日志结果,即可查看使用安装的 pandas 库,正确打印了安装的 sklearn 库的版本。

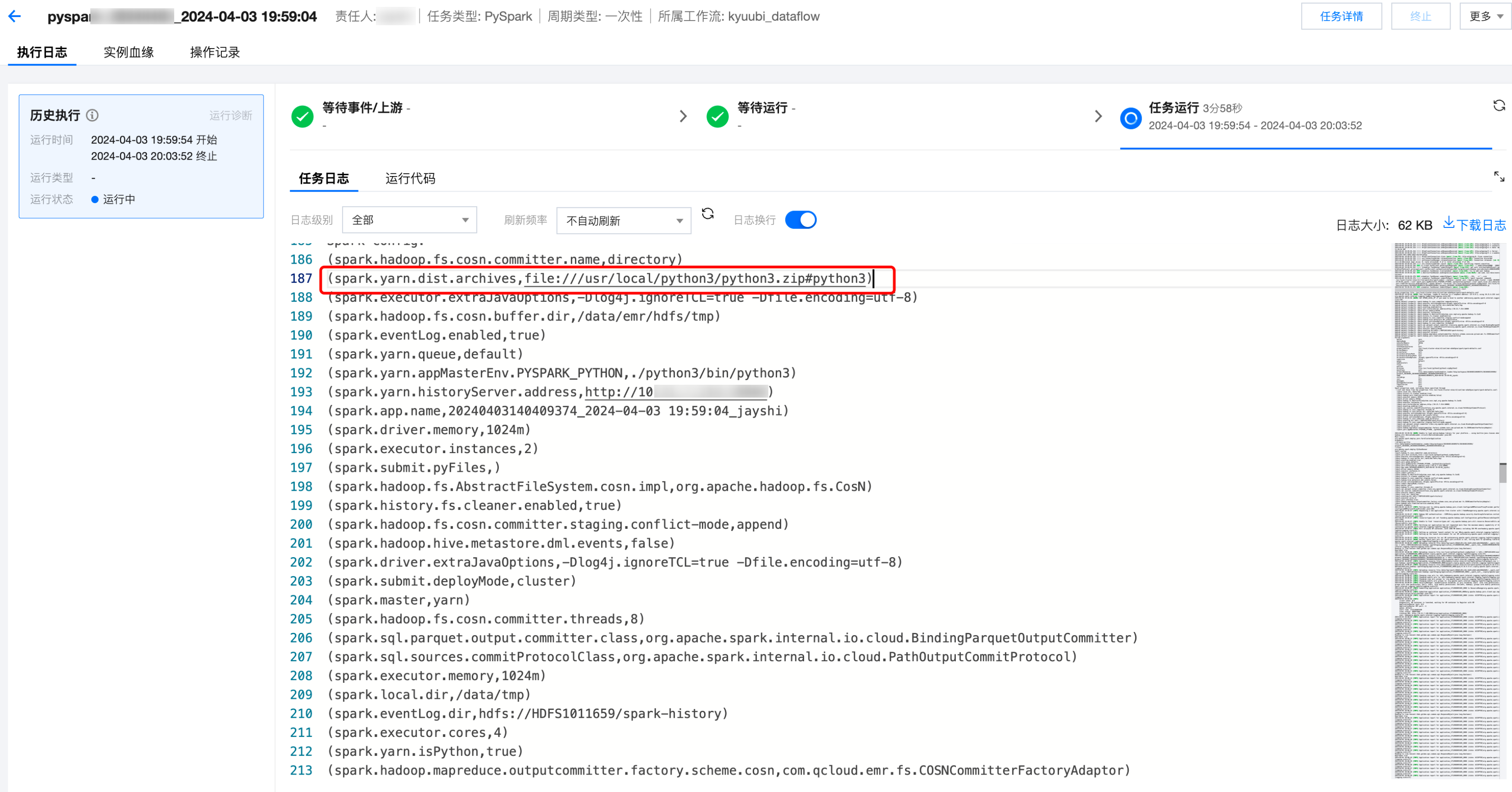

周期调度 PySpark 任务

周期调度运行,查看调试运行的日志和结果。日志中可以查看使用调度资源组的 Python 环境作为任务运行的环境。

是

是

否

否

本页内容是否解决了您的问题?