- 动态与公告

- 产品简介

- 购买指南

- 快速入门

- TKE 标准集群指南

- TKE 标准集群概述

- 购买 TKE 标准集群

- 容器服务高危操作

- 云上容器应用部署 Check List

- 开源组件

- 权限管理

- 集群管理

- 镜像

- Worker 节点介绍

- 普通节点管理

- 原生节点管理

- 超级节点管理

- 注册节点管理

- 内存压缩

- GPU 共享

- Kubernetes 对象管理

- Service 管理

- Ingress 管理

- 存储管理

- 策略管理

- 应用与组件功能管理说明

- 组件管理

- 扩展组件概述

- 组件的生命周期管理

- Cluster Autoscaler 说明

- OOMGuard 说明

- NodeProblemDetectorPlus 说明

- NodeLocalDNSCache 说明

- DNSAutoscaler 说明

- COS-CSI 说明

- CFS-CSI 说明

- CFSTURBO-CSI 说明

- CBS-CSI 说明

- UserGroupAccessControl 说明

- TCR 说明

- TCR Hosts Updater

- DynamicScheduler 说明

- DeScheduler 说明

- Network Policy 说明

- Nginx-ingress 说明

- HPC 说明

- tke-monitor-agent 说明

- tke-log-agent 说明

- GPU-Manager 说明

- 应用管理

- 应用市场

- 网络管理

- 集群运维

- 日志管理

- 备份中心

- 远程终端

- TKE Serverless 集群指南

- TKE 注册集群指南

- TKE Insight

- TKE 调度

- 云原生服务指南

- 实践教程

- 集群

- 集群迁移

- Serverless 集群

- 调度

- 安全

- 服务部署

- 网络

- 发布

- 日志

- 监控

- 运维

- Terraform

- DevOps

- 弹性伸缩

- 容器化

- 微服务

- 成本管理

- 混合云

- 故障处理

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- Elastic Cluster APIs

- Resource Reserved Coupon APIs

- Cluster APIs

- AcquireClusterAdminRole

- CreateClusterEndpoint

- CreateClusterEndpointVip

- DeleteCluster

- DeleteClusterEndpoint

- DeleteClusterEndpointVip

- DescribeAvailableClusterVersion

- DescribeClusterAuthenticationOptions

- DescribeClusterCommonNames

- DescribeClusterEndpointStatus

- DescribeClusterEndpointVipStatus

- DescribeClusterEndpoints

- DescribeClusterKubeconfig

- DescribeClusterLevelAttribute

- DescribeClusterLevelChangeRecords

- DescribeClusterSecurity

- DescribeClusterStatus

- DescribeClusters

- DescribeEdgeAvailableExtraArgs

- DescribeEdgeClusterExtraArgs

- DescribeResourceUsage

- DisableClusterDeletionProtection

- EnableClusterDeletionProtection

- GetClusterLevelPrice

- GetUpgradeInstanceProgress

- ModifyClusterAttribute

- ModifyClusterAuthenticationOptions

- ModifyClusterEndpointSP

- UpgradeClusterInstances

- CreateBackupStorageLocation

- CreateCluster

- DeleteBackupStorageLocation

- DescribeBackupStorageLocations

- DescribeEncryptionStatus

- DisableEncryptionProtection

- EnableEncryptionProtection

- UpdateClusterKubeconfig

- UpdateClusterVersion

- Third-party Node APIs

- Network APIs

- Node APIs

- Node Pool APIs

- TKE Edge Cluster APIs

- CheckEdgeClusterCIDR

- DescribeAvailableTKEEdgeVersion

- DescribeECMInstances

- DescribeEdgeCVMInstances

- DescribeEdgeClusterInstances

- DescribeEdgeClusterUpgradeInfo

- DescribeTKEEdgeClusterStatus

- ForwardTKEEdgeApplicationRequestV3

- DescribeEdgeLogSwitches

- CreateECMInstances

- CreateEdgeCVMInstances

- CreateEdgeLogConfig

- DeleteECMInstances

- DeleteEdgeCVMInstances

- DeleteEdgeClusterInstances

- DeleteTKEEdgeCluster

- DescribeTKEEdgeClusterCredential

- DescribeTKEEdgeExternalKubeconfig

- DescribeTKEEdgeScript

- InstallEdgeLogAgent

- UninstallEdgeLogAgent

- UpdateEdgeClusterVersion

- DescribeTKEEdgeClusters

- CreateTKEEdgeCluster

- Cloud Native Monitoring APIs

- Scaling group APIs

- Super Node APIs

- Add-on APIs

- Other APIs

- Data Types

- Error Codes

- TKE API 2022-05-01

- 常见问题

- 服务协议

- 联系我们

- 词汇表

- 动态与公告

- 产品简介

- 购买指南

- 快速入门

- TKE 标准集群指南

- TKE 标准集群概述

- 购买 TKE 标准集群

- 容器服务高危操作

- 云上容器应用部署 Check List

- 开源组件

- 权限管理

- 集群管理

- 镜像

- Worker 节点介绍

- 普通节点管理

- 原生节点管理

- 超级节点管理

- 注册节点管理

- 内存压缩

- GPU 共享

- Kubernetes 对象管理

- Service 管理

- Ingress 管理

- 存储管理

- 策略管理

- 应用与组件功能管理说明

- 组件管理

- 扩展组件概述

- 组件的生命周期管理

- Cluster Autoscaler 说明

- OOMGuard 说明

- NodeProblemDetectorPlus 说明

- NodeLocalDNSCache 说明

- DNSAutoscaler 说明

- COS-CSI 说明

- CFS-CSI 说明

- CFSTURBO-CSI 说明

- CBS-CSI 说明

- UserGroupAccessControl 说明

- TCR 说明

- TCR Hosts Updater

- DynamicScheduler 说明

- DeScheduler 说明

- Network Policy 说明

- Nginx-ingress 说明

- HPC 说明

- tke-monitor-agent 说明

- tke-log-agent 说明

- GPU-Manager 说明

- 应用管理

- 应用市场

- 网络管理

- 集群运维

- 日志管理

- 备份中心

- 远程终端

- TKE Serverless 集群指南

- TKE 注册集群指南

- TKE Insight

- TKE 调度

- 云原生服务指南

- 实践教程

- 集群

- 集群迁移

- Serverless 集群

- 调度

- 安全

- 服务部署

- 网络

- 发布

- 日志

- 监控

- 运维

- Terraform

- DevOps

- 弹性伸缩

- 容器化

- 微服务

- 成本管理

- 混合云

- 故障处理

- API 文档

- History

- Introduction

- API Category

- Making API Requests

- Elastic Cluster APIs

- Resource Reserved Coupon APIs

- Cluster APIs

- AcquireClusterAdminRole

- CreateClusterEndpoint

- CreateClusterEndpointVip

- DeleteCluster

- DeleteClusterEndpoint

- DeleteClusterEndpointVip

- DescribeAvailableClusterVersion

- DescribeClusterAuthenticationOptions

- DescribeClusterCommonNames

- DescribeClusterEndpointStatus

- DescribeClusterEndpointVipStatus

- DescribeClusterEndpoints

- DescribeClusterKubeconfig

- DescribeClusterLevelAttribute

- DescribeClusterLevelChangeRecords

- DescribeClusterSecurity

- DescribeClusterStatus

- DescribeClusters

- DescribeEdgeAvailableExtraArgs

- DescribeEdgeClusterExtraArgs

- DescribeResourceUsage

- DisableClusterDeletionProtection

- EnableClusterDeletionProtection

- GetClusterLevelPrice

- GetUpgradeInstanceProgress

- ModifyClusterAttribute

- ModifyClusterAuthenticationOptions

- ModifyClusterEndpointSP

- UpgradeClusterInstances

- CreateBackupStorageLocation

- CreateCluster

- DeleteBackupStorageLocation

- DescribeBackupStorageLocations

- DescribeEncryptionStatus

- DisableEncryptionProtection

- EnableEncryptionProtection

- UpdateClusterKubeconfig

- UpdateClusterVersion

- Third-party Node APIs

- Network APIs

- Node APIs

- Node Pool APIs

- TKE Edge Cluster APIs

- CheckEdgeClusterCIDR

- DescribeAvailableTKEEdgeVersion

- DescribeECMInstances

- DescribeEdgeCVMInstances

- DescribeEdgeClusterInstances

- DescribeEdgeClusterUpgradeInfo

- DescribeTKEEdgeClusterStatus

- ForwardTKEEdgeApplicationRequestV3

- DescribeEdgeLogSwitches

- CreateECMInstances

- CreateEdgeCVMInstances

- CreateEdgeLogConfig

- DeleteECMInstances

- DeleteEdgeCVMInstances

- DeleteEdgeClusterInstances

- DeleteTKEEdgeCluster

- DescribeTKEEdgeClusterCredential

- DescribeTKEEdgeExternalKubeconfig

- DescribeTKEEdgeScript

- InstallEdgeLogAgent

- UninstallEdgeLogAgent

- UpdateEdgeClusterVersion

- DescribeTKEEdgeClusters

- CreateTKEEdgeCluster

- Cloud Native Monitoring APIs

- Scaling group APIs

- Super Node APIs

- Add-on APIs

- Other APIs

- Data Types

- Error Codes

- TKE API 2022-05-01

- 常见问题

- 服务协议

- 联系我们

- 词汇表

本文介绍如何使用新版容器服务控制台快速创建标准 TKE 集群,您可在集群创建完毕后再创建 Worker Node。

前提条件

在创建集群前,您需要完成以下工作:

集群创建过程中将使用私有网络、子网、安全组等多种资源。资源所在地域具备一定的配额限制,详情请参见 购买集群配额限制。

通过控制台创建集群

2. 单击集群列表上方的新建。

3. 在集群类型中,选择标准集群,单击创建。

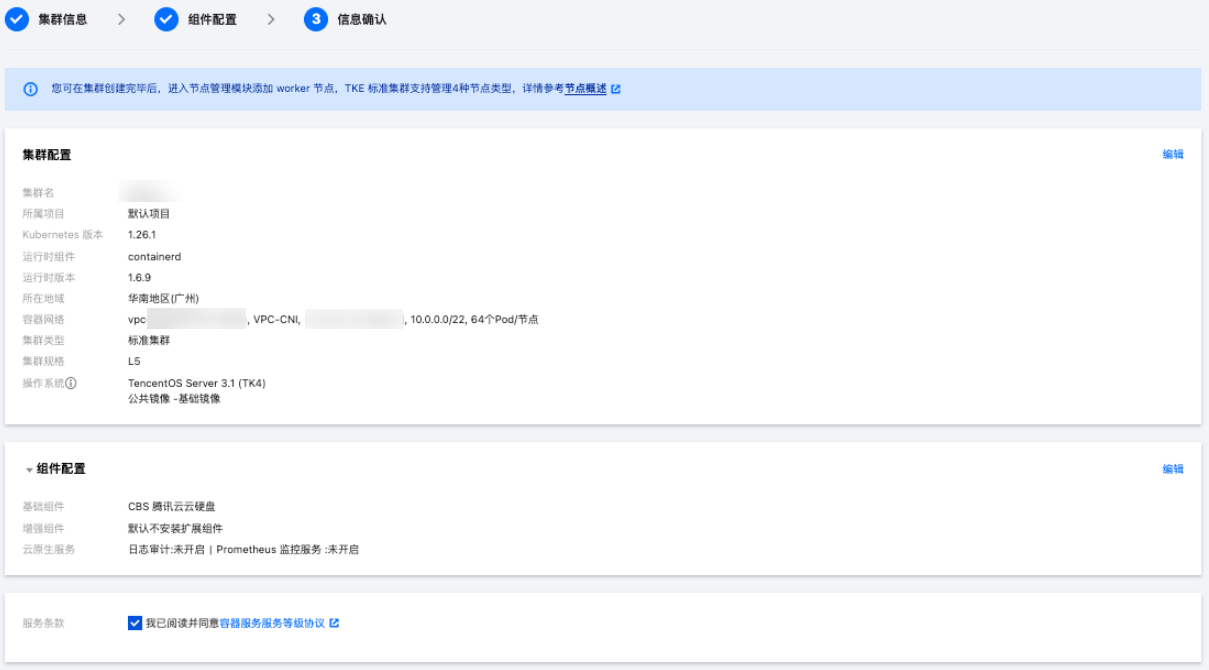

1. (必填)填写集群信息

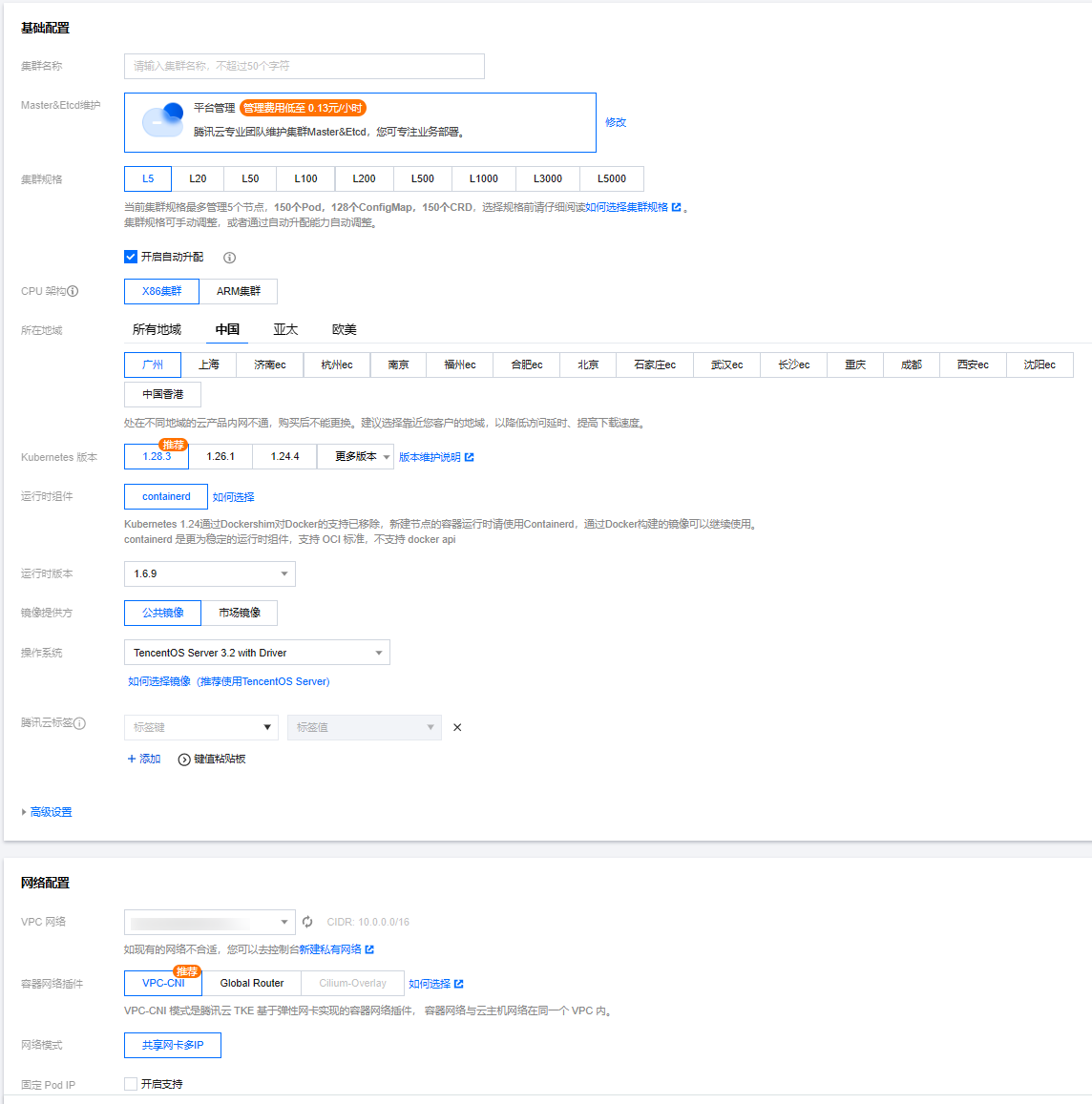

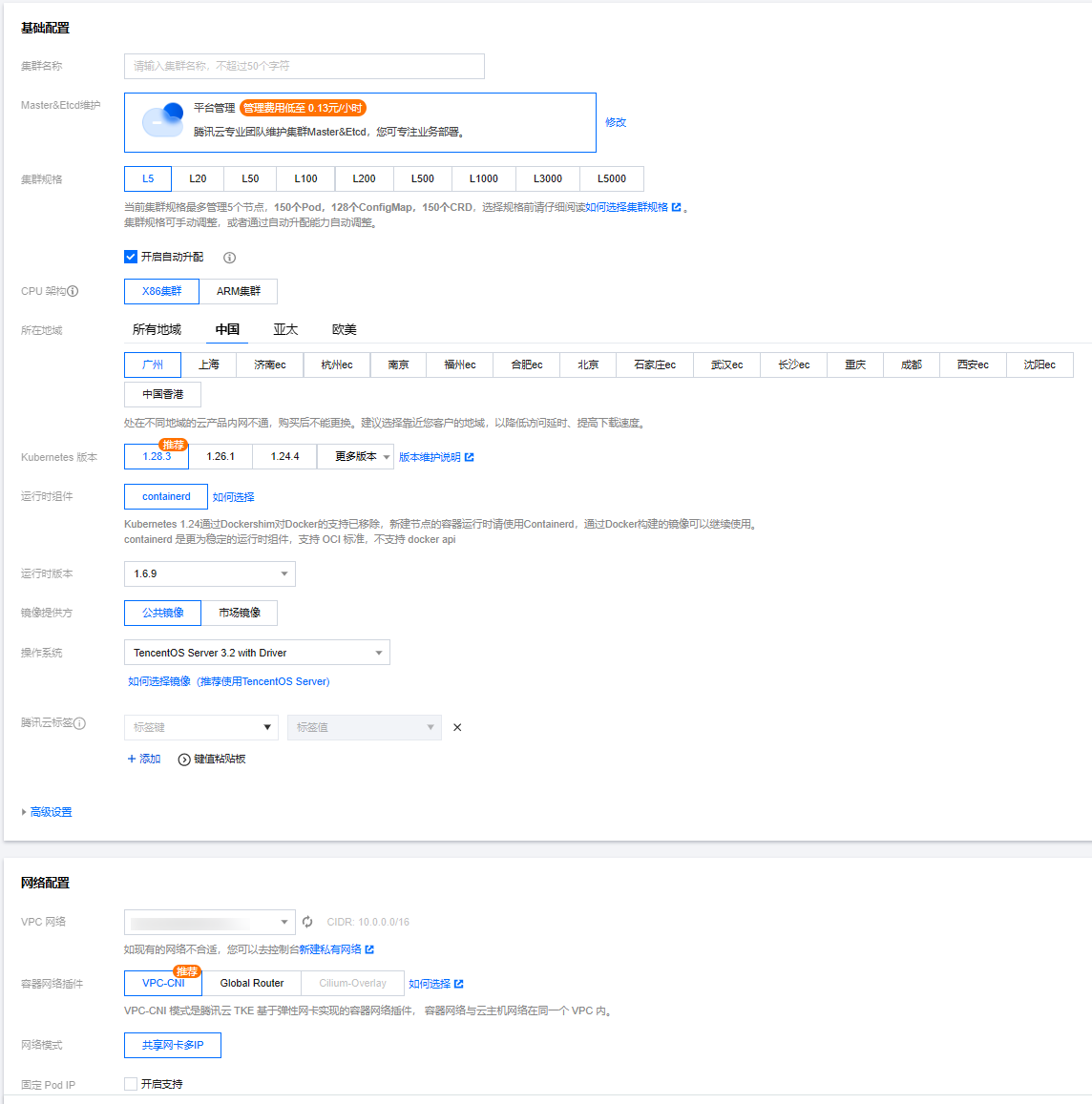

在集群信息页面,设置集群的基础配置和网络配置。如下图所示:

基础配置核心参数说明

参数名称 | 使用说明 |

集群名称 | 输入要创建的集群名称,不超过50个字符。 |

Master&Etcd 维护 | 平台管理:由腾讯云专业团队维护集群控制面组件,需支付一定的管理费用,详情请参见 集群管理费用。 自行维护:需用户自行购买、维护和管理控制面资源,平台不提供服务保障。 |

集群规格 | |

Kubernetes 版本 | |

运行时组件 | 推荐您选择 Containerd 支持的最新版本。(Kubernetes 1.24通过 Dockershim 对 Docker 的支持已移除,TKE 新建节点的容器运行时仅支持 Containerd 1.6.9。) |

操作系统 | |

腾讯云标签 | 为集群绑定标签后可实现资源的分类管理,在集群内创建的云资源会默认继承集群标签。 |

高级设置 | 节点 hostname 命名模式:主机和节点命名规则,支持设置“自动命名(默认为内网 IP)”和“手动命名”。

新增资源所属项目:根据实际需求进行选择,新增的资源将会自动分配到该项目下。 |

网络配置核心参数说明

参数名称 | 使用说明 |

VPC 网络 | |

容器网络插件 | CNI (Container Network Interface) 网络插件是一种用于 Kubernetes 集群的网络解决方案,旨在提供灵活、可扩展和高性能的网络连接。CNI TKE 网络插件遵循 CNI 规范,允许 Kubernetes 集群与各种网络解决方案无缝集成,以满足不同的业务需求和性能要求。TKE 提供了3种网络 CNI 插件方案:VPC-CNI、Global Router 和 Cilium-Overlay,详情请参见 如何选择容器网络模式。 注意: TKE 推荐用户在公有云场景下使用 “VPC-CNI” 网络方案,在注册节点场景下使用 “Cilium-Overlay” 网络方案。 VPC-CNI 网络方案 TKE 默认推荐用户使用VPC-CNI 方案。VPC-CNI 网络方案是 TKE 基于腾讯云 VPC 实现的容器网络接口 CNI,可以将 VPC 原生的弹性网卡直接分配给 Pod,实现 Pod 之间的网络互联,适用于对时延有较高需求的场景。该网络模式下,容器与节点分布在同一网络平面,容器 IP 为 IPAMD 组件分配的弹性网卡 IP。详情请参见 VPC-CNI 方案介绍。

Global Router 网络方案

Global Router 网络方案是 TKE 基于腾讯云 VPC 的全局路由能力实现的容器网络接口 CNI。其中 Pod CIDR 网段独立于 VPC 的 CIDR 网段,不同节点的 Pod CIDR 信息会通过全局路由方式下发到 VPC,实现跨节点 Pod 的互访。详情请参见 Global Router 方案介绍。

Cilium-Overlay 网络方案

Cilium-Overlay 网络方案是 TKE 基于 Cilium VXLan 实现的容器网络插件,实现分布式云场景中,注册节点添加到 TKE 集群的网络管理。详情请参见 Cilium-Overlay 方案介绍。 |

高级设置 |

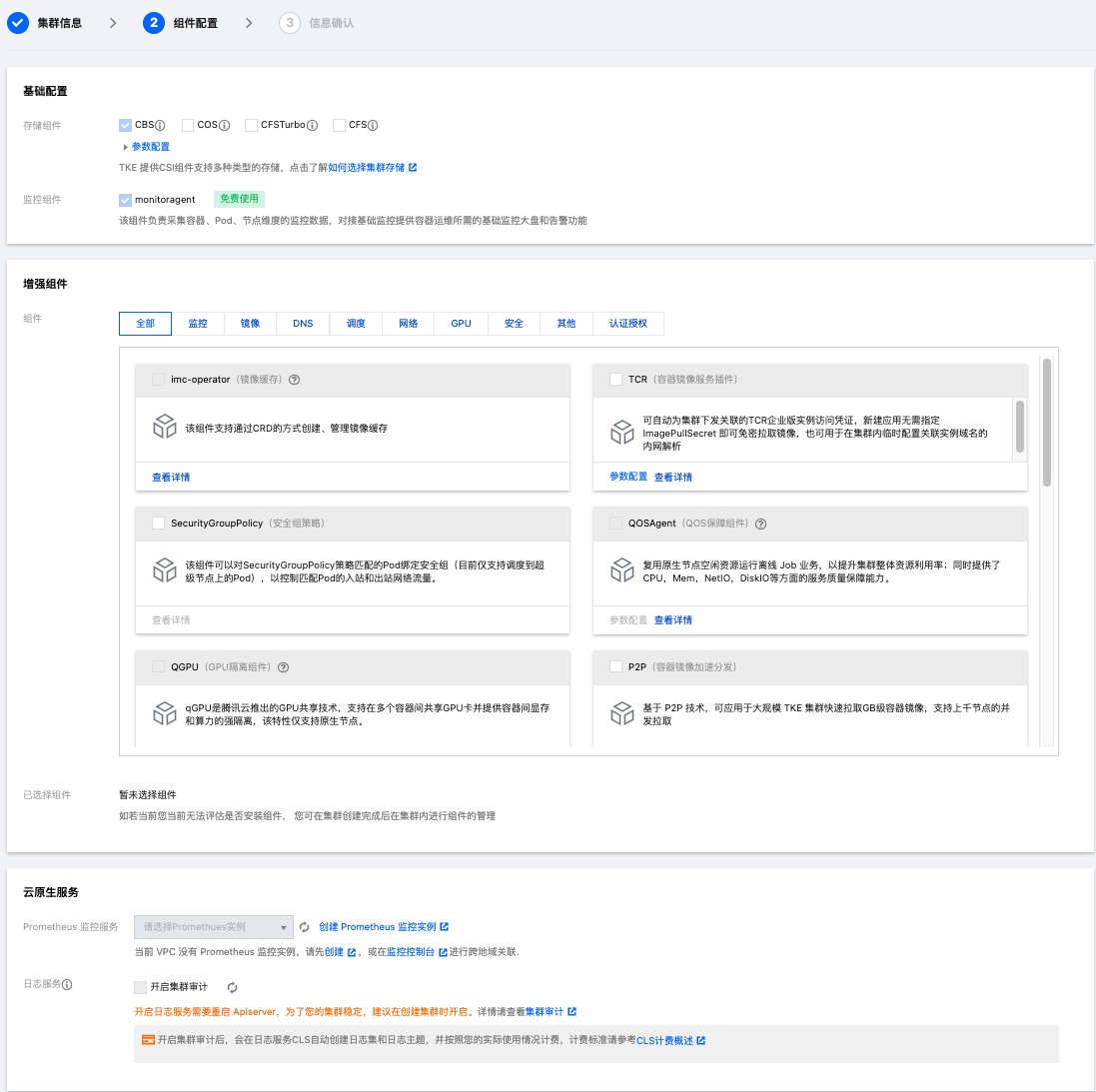

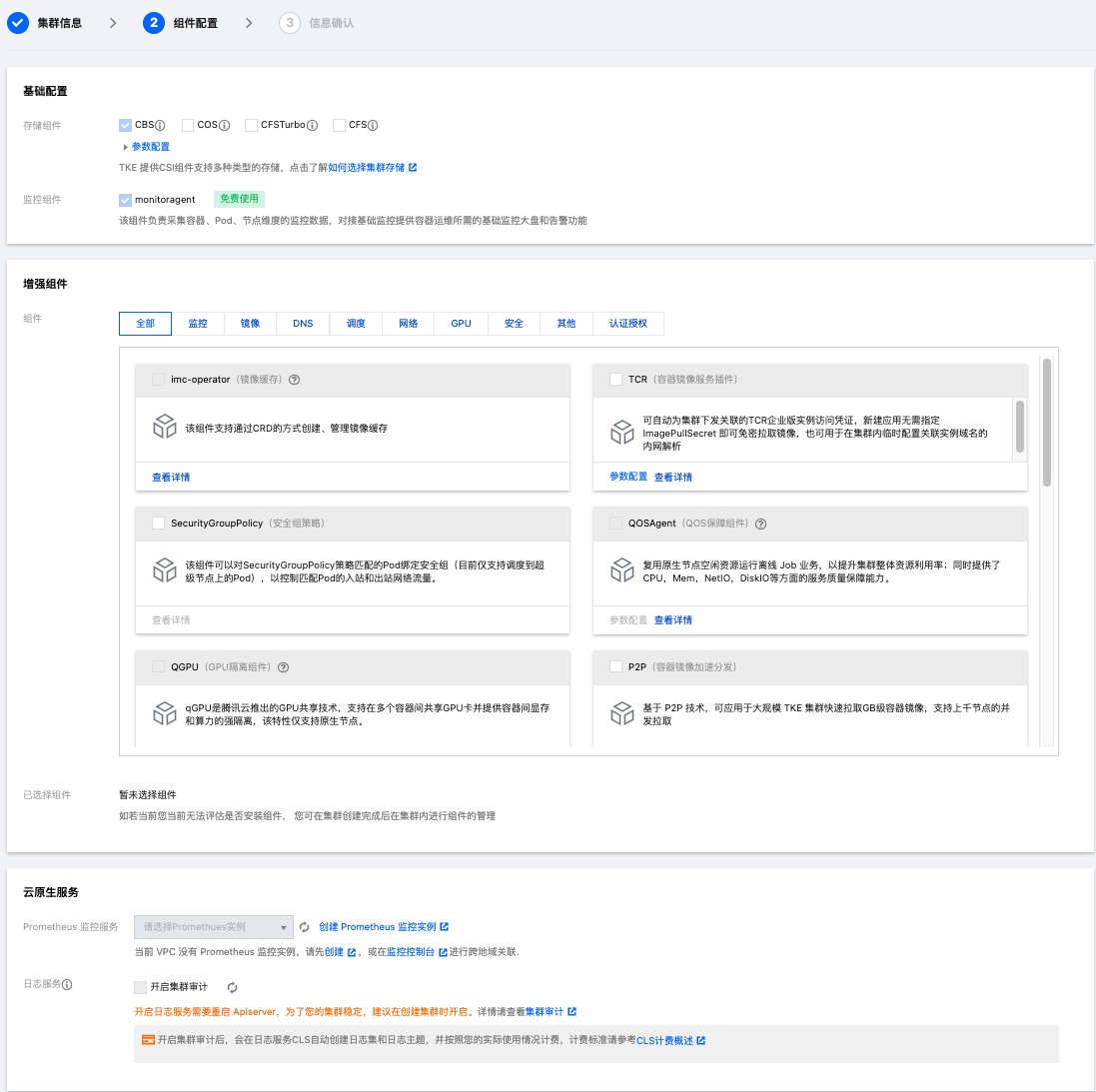

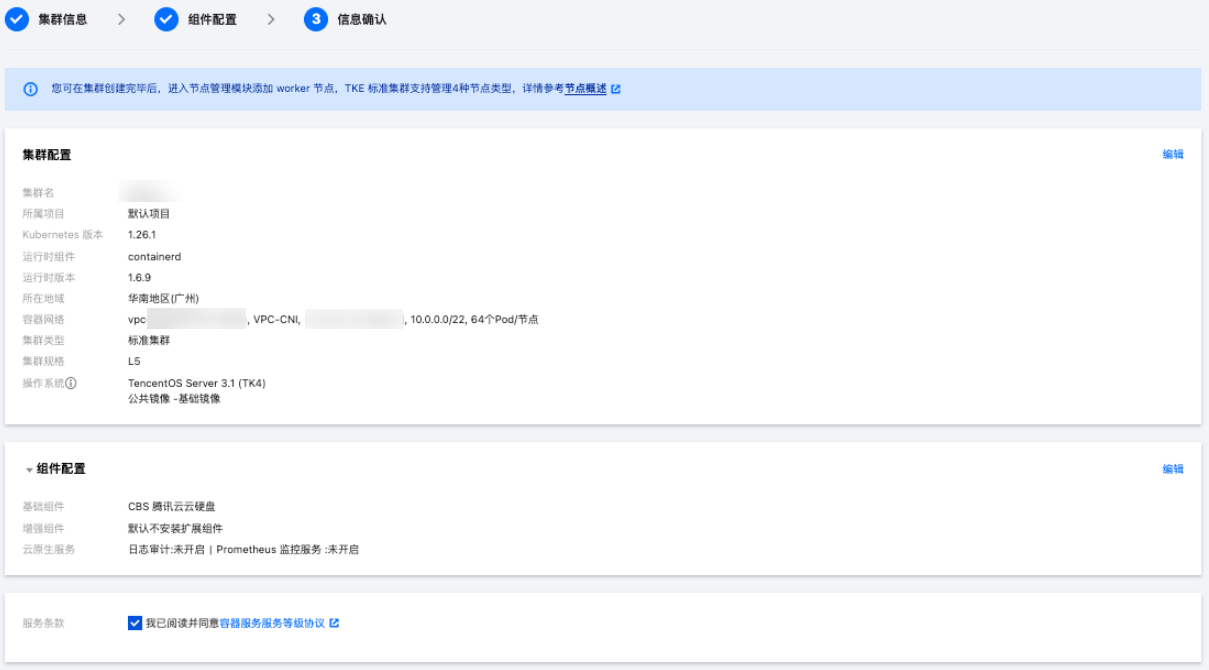

2. (选填)填写组件配置

说明:

在组件配置页面,设置集群的组件和云原生服务,如下图所示:

云原生服务参数说明

参数名称 | 使用说明 |

Prometheus 监控服务 | |

日志服务 |

3. 信息确认

单击完成即可创建一个不包含 Worker Node 的 TKE 标准集群。

是

是

否

否

本页内容是否解决了您的问题?