- 릴리스 노트 및 공지 사항

- 제품 소개

- 구매 가이드

- 시작하기

- 콘솔 가이드

- 툴 가이드

- 툴 개요

- 환경 설치 및 설정

- COSBrowser 툴

- COSCLI 툴

- COSCLI 소개

- 다운로드 및 설치 설정

- 범용 옵션

- 자주 쓰는 명령어

- 프로파일 생성 및 수정 - config

- 버킷 생성 - mb

- 버킷 삭제 - rb

- 버킷 태그 - bucket-tagging

- 버킷 또는 파일 리스트 쿼리 - ls

- 파일 유형별 통계 정보 가져오기 - du

- 파일 업/다운로드 또는 복사 - cp

- 파일 동기화 업/다운로드 또는 복사 - sync

- 파일 삭제 - rm

- 파일 해시 값 가져오기 - hash

- 멀티파트 업로드에서 생성된 조각 나열 - lsparts

- 조각 정리 - abort

- 아카이브 파일 검색 - restore

- 소프트 링크 생성/획득 - symlink

- 객체 내용 보기 - cat

- 목록하의 내용 열거 및 통계 - Isdu

- FAQ

- COSCMD 툴

- COS Migration 툴

- FTP Server 툴

- Hadoop 툴

- COSDistCp 툴

- Hadoop-cos-DistChecker 툴

- HDFS TO COS 툴

- 온라인 보조 툴

- 자가 진단 도구

- 사례 튜토리얼

- 개발자 가이드

- 데이터 레이크 스토리지

- 데이터 처리

- 장애 처리

- FAQ

- Related Agreements

- 용어집

- 릴리스 노트 및 공지 사항

- 제품 소개

- 구매 가이드

- 시작하기

- 콘솔 가이드

- 툴 가이드

- 툴 개요

- 환경 설치 및 설정

- COSBrowser 툴

- COSCLI 툴

- COSCLI 소개

- 다운로드 및 설치 설정

- 범용 옵션

- 자주 쓰는 명령어

- 프로파일 생성 및 수정 - config

- 버킷 생성 - mb

- 버킷 삭제 - rb

- 버킷 태그 - bucket-tagging

- 버킷 또는 파일 리스트 쿼리 - ls

- 파일 유형별 통계 정보 가져오기 - du

- 파일 업/다운로드 또는 복사 - cp

- 파일 동기화 업/다운로드 또는 복사 - sync

- 파일 삭제 - rm

- 파일 해시 값 가져오기 - hash

- 멀티파트 업로드에서 생성된 조각 나열 - lsparts

- 조각 정리 - abort

- 아카이브 파일 검색 - restore

- 소프트 링크 생성/획득 - symlink

- 객체 내용 보기 - cat

- 목록하의 내용 열거 및 통계 - Isdu

- FAQ

- COSCMD 툴

- COS Migration 툴

- FTP Server 툴

- Hadoop 툴

- COSDistCp 툴

- Hadoop-cos-DistChecker 툴

- HDFS TO COS 툴

- 온라인 보조 툴

- 자가 진단 도구

- 사례 튜토리얼

- 개발자 가이드

- 데이터 레이크 스토리지

- 데이터 처리

- 장애 처리

- FAQ

- Related Agreements

- 용어집

소개

CDH(Cloudera's Distribution, including Apache Hadoop)는 업계에서 각광받는 Hadoop의 릴리스 버전입니다. 본 문서는 CDH 환경에서 HDFS 프로토콜을 통해 객체 스토리지(Cloud Object Storage, COS) 버킷에 액세스하는 방법을 소개합니다. 이 기능을 통해 빅 데이터 컴퓨팅과 스토리지를 분리하여 효율적인 저비용 빅 데이터 솔루션을 제공합니다.

주의:HDFS 프로토콜을 통해 COS 버킷에 액세스하려면 먼저 메타데이터 가속 기능을 활성화해야 합니다.

빅 데이터 컴포넌트에 대한 현재 COS 지원은 다음과 같습니다.

| 모듈 이름 | CHDFS 빅 데이터 모듈 지원 현황 | 서비스 모듈 재시작 필요 여부 |

|---|---|---|

| Yarn | 지원 | NodeManager 재시작 |

| Yarn | 지원 | NodeManager 재시작 |

| Hive | 지원 | HiveServer 및 HiveMetastore 재시작 |

| Spark | 지원 | NodeManager 재시작 |

| Sqoop | 지원 | NodeManager 재시작 |

| Presto | 지원 | HiveServer, HiveMetastore, Presto 재시작 |

| Flink | 지원 | 필요 없음 |

| Impala | 지원 | 필요 없음 |

| EMR | 지원 | 필요 없음 |

| 자체구축 모듈 | 향후 지원 | 없음 |

| HBase | 권장하지 않음 | 없음 |

버전 종속

본 문서에 종속된 모듈 버전은 다음과 같습니다.

- CDH 5.16.1

- Hadoop 2.6.0

사용 방법

스토리지 환경 설정

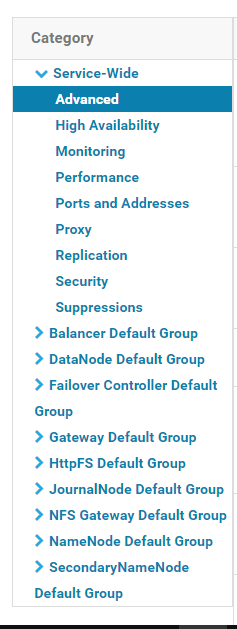

- CDH 관리 페이지에 로그인합니다.

- 시스템 메인 페이지에서 설정>서비스 범위>고급을 선택하여 코드 스니펫 고급 설정 페이지로 이동하면 다음 그림과 같이 표시됩니다.

Cluster-wide Advanced Configuration Snippet(Safety Valve) for core-site.xml코드 창에 COS 빅 데이터 서비스 설정을 입력합니다.<property> <name>fs.AbstractFileSystem.ofs.impl</name> <value>com.qcloud.chdfs.fs.CHDFSDelegateFSAdapter</value> </property> <property> <name>fs.ofs.impl</name> <value>com.qcloud.chdfs.fs.CHDFSHadoopFileSystemAdapter</value> </property> <!--로컬 cache의 임시 디렉터리로, 데이터 읽기/쓰기의 경우 메모리 cache가 부족할 때는 로컬 디스크에 쓰기 하고 관련 경로가 없을 때는 자동 생성합니다.--> <property> <name>fs.ofs.tmp.cache.dir</name> <value>/data/emr/hdfs/tmp/chdfs/</value> </property> <!--appId--> <property> <name>fs.ofs.user.appid</name> <value>1250000000</value> </property>

다음은 필수 설정 항목(core-site.xml에 추가 필요)입니다. 기타 설정 항목은 컴퓨팅 클러스터에 COS 버킷 마운트를 참고하십시오.

| 설정 항목 | 값 | 의미 |

|---|---|---|

| fs.ofs.user.appid | 1250000000 | 사용자 appid |

| fs.ofs.tmp.cache.dir | /data/emr/hdfs/tmp/chdfs/ | 로컬 cache용 임시 디렉터리 |

| fs.ofs.impl | com.qcloud.chdfs.fs.CHDFSHadoopFileSystemAdapter | FileSystem용 chdfs 구현 클래스, com.qcloud.chdfs.fs.CHDFSHadoopFileSystemAdapter로 고정 |

| fs.AbstractFileSystem.ofs.impl | com.qcloud.chdfs.fs.CHDFSDelegateFSAdapter | AbstractFileSystem용 chdfs 구현 클래스, com.qcloud.chdfs.fs.CHDFSDelegateFSAdapter로 고정 |

cp chdfs_hadoop_plugin_network-2.0.jar /opt/cloudera/parcels/CDH-5.16.1-1.cdh5.16.1.p0.3/lib/hadoop-hdfs/

주의:클러스터의 기기마다 동일한 위치에 SDK 패키지를 설치해야 합니다.

데이터 마이그레이션

Hadoop Distcp 툴을 사용해 CDH HDFS 데이터를 COS 버킷에 마이그레이션합니다. 자세한 내용은 Hadoop 파일 시스템과 COS 간의 데이터 마이그레이션을 참고하십시오.

빅 데이터 세트로 CHDFS 사용

MapReduce

작업 단계

- 데이터 마이그레이션 섹션에 따라 HDFS 관련 설정을 완료하고, COS의 클라이언트 설치 패키지를 HDFS의 해당 디렉터리에 넣습니다.

- CDH 시스템 메인 페이지에서 YARN을 찾아 NodeManager 서비스를 재시작합니다. TeraGen 명령어는 재시작할 필요가 없으나 TeraSort는 비즈니스 내부 로직으로 인해 NodeManger를 재시작해야 하므로, NodeManager 서비스를 일괄 재시작할 것을 권장합니다.

예시

Hadoop 표준 테스트의 TeraGen 및 TeraSort입니다.

hadoop jar ./hadoop-mapreduce-examples-2.7.3.jar teragen -Dmapred.map.tasks=4 1099 ofs://examplebucket-1250000000/teragen_5/

hadoop jar ./hadoop-mapreduce-examples-2.7.3.jar terasort -Dmapred.map.tasks=4 ofs://examplebucket-1250000000/teragen_5/ ofs://examplebucket-1250000000/result14

설명:

ofs:// schema뒷부분을 사용자 CHDFS의 마운트 포인트 경로로 변경하십시오.

Hive

MR 엔진

작업 단계

- 데이터 마이그레이션 섹션에 따라 HDFS 관련 설정을 완료하고, COS의 클라이언트 설치 패키지를 HDFS의 해당 디렉터리에 넣습니다.

- CDH 메인 페이지에서 HIVE 서비스를 찾아 Hiveserver2와 HiverMetastore 역할을 재시작합니다.

예시

사용자의 실제 작업 쿼리입니다. Hive 명령 라인을 실행하여 Location을 생성하고, 이를 CHDFS의 파티션 테이블로 사용하는 경우입니다.

CREATE TABLE `report.report_o2o_pid_credit_detail_grant_daily`(

`cal_dt` string,

`change_time` string,

`merchant_id` bigint,

`store_id` bigint,

`store_name` string,

`wid` string,

`member_id` bigint,

`meber_card` string,

`nickname` string,

`name` string,

`gender` string,

`birthday` string,

`city` string,

`mobile` string,

`credit_grant` bigint,

`change_reason` string,

`available_point` bigint,

`date_time` string,

`channel_type` bigint,

`point_flow_id` bigint)

PARTITIONED BY (

`topicdate` string)

ROW FORMAT SERDE

'org.apache.hadoop.hive.ql.io.orc.OrcSerde'

STORED AS INPUTFORMAT

'org.apache.hadoop.hive.ql.io.orc.OrcInputFormat'

OUTPUTFORMAT

'org.apache.hadoop.hive.ql.io.orc.OrcOutputFormat'

LOCATION

'ofs://examplebucket-1250000000/user/hive/warehouse/report.db/report_o2o_pid_credit_detail_grant_daily'

TBLPROPERTIES (

'last_modified_by'='work',

'last_modified_time'='1589310646',

'transient_lastDdlTime'='1589310646')

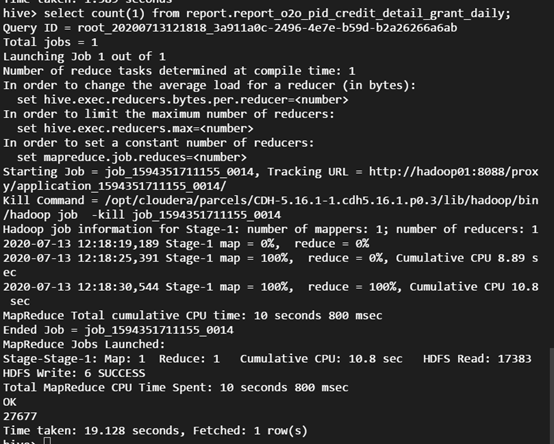

SQL 쿼리 실행:

select count(1) from report.report_o2o_pid_credit_detail_grant_daily;

모니터링 결과는 다음과 같습니다.

Tez 엔진

Tez 엔진은 COS의 클라이언트 설치 패키지를 Tez의 압축 패키지 내로 가져와야 합니다. 다음은 apache-tez.0.8.5를 예시로 한 설명입니다.

작업 단계

- CDH 클러스터에 설치한 tez 패키지를 찾은 후 압축을 해제합니다. /usr/local/service/tez/tez-0.8.5.tar.gz를 예로 들 수 있습니다.

- 압축 해제된 디렉터리에 COS 클라이언트 설치 패키지를 넣고 다시 압축하여 압축된 패키지를 출력합니다.

- 새로 생성한 압축 패키지를 tez.lib.uris에서 지정한 경로(경로가 이미 있는 경우 변경 가능)에 업로드합니다.

- CDH 메인 페이지에서 HIVE를 찾아 hiveserver와 hivemetastore를 재시작합니다.

Spark

작업 단계

- 데이터 마이그레이션 섹션에 따라 HDFS 관련 설정을 완료하고, COS의 클라이언트 설치 패키지를 HDFS의 해당 디렉터리에 넣습니다.

- NodeManager 서비스를 재시작합니다.

예시

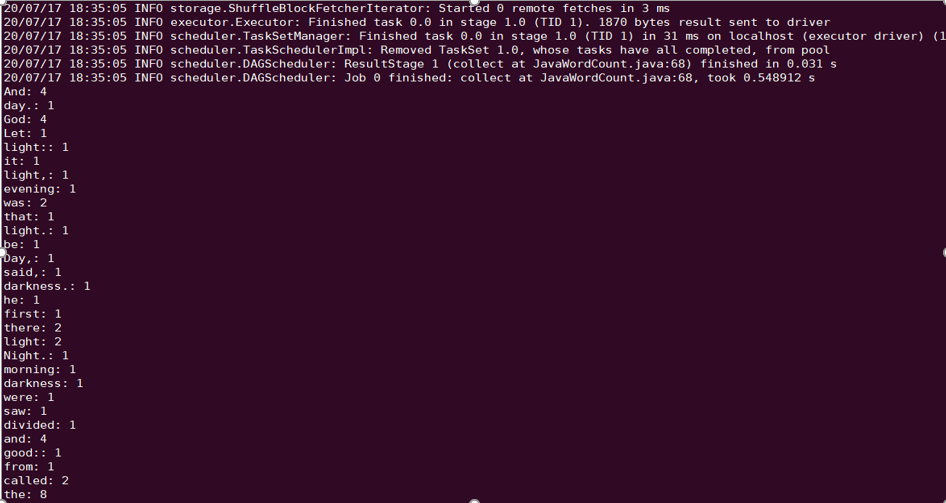

Spark example word count 테스트를 진행합니다.

spark-submit --class org.apache.spark.examples.JavaWordCount --executor-memory 4g --executor-cores 4 ./spark-examples-1.6.0-cdh5.16.1-hadoop2.6.0-cdh5.16.1.jar ofs://examplebucket-1250000000/wordcount

실행 결과는 다음과 같습니다.

Sqoop

작업 단계

- 데이터 마이그레이션 섹션에 따라 HDFS 관련 설정을 완료하고, COS의 클라이언트 설치 패키지를 HDFS의 해당 디렉터리에 넣습니다.

- COS의 클라이언트 설치 패키지를 sqoop 디렉터리에 넣어야 합니다(예시: /opt/cloudera/parcels/CDH-5.16.1-1.cdh5.16.1.p0.3/lib/sqoop/).

- NodeManager 서비스를 재시작합니다.

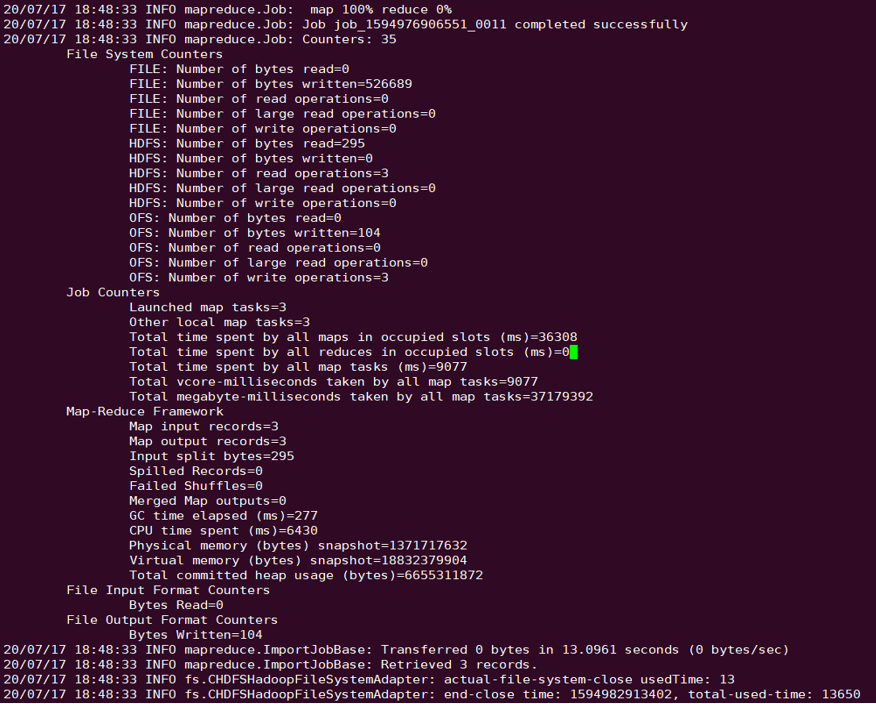

예시

MYSQL 테이블을 COS에 내보냅니다. 관계형 데이터베이스 및 HDFS의 가져오기/내보내기 문서를 참고하여 테스트를 진행하십시오.

sqoop import --connect "jdbc:mysql://IP:PORT/mysql" --table sqoop_test --username root --password 123 --target-dir ofs://examplebucket-1250000000/sqoop_test

실행 결과는 다음과 같습니다.

Presto

작업 단계

- 데이터 마이그레이션 섹션에 따라 HDFS 관련 설정을 완료하고, COS의 클라이언트 설치 패키지를 HDFS의 해당 디렉터리에 넣습니다.

- COS의 클라이언트 설치 패키지를 presto 디렉터리에 넣어야 합니다(예시: /usr/local/services/cos_presto/plugin/hive-hadoop2).

- presto는 hadoop common의 gson-2...jar를 로딩할 수 없으므로 gson-2...jar 또한 presto 디렉터리에 넣어야 합니다(예시: /usr/local/services/cos_presto/plugin/hive-hadoop2, COS만 gson에 종속됨).

- HiveServer, HiveMetaStore, Presto 서비스를 재시작합니다.

예시

HIVE에서 Location이 COS인 테이블 쿼리 생성:

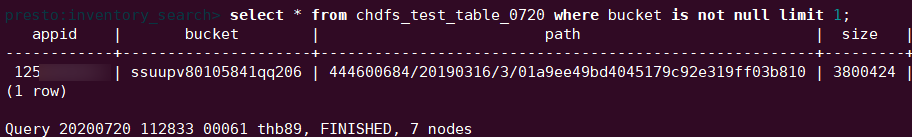

select * from chdfs_test_table where bucket is not null limit 1;

설명:chdfs_test_table은 location이 ofs scheme인 테이블입니다.

쿼리 결과는 다음과 같습니다.

예

예

아니오

아니오

문제 해결에 도움이 되었나요?